共计 1021 个字符,预计需要花费 3 分钟才能阅读完成。

一、Hadoop 的启动

在阅读这篇文章之前,你应该先阅读:Hadoop 的安装与环境搭建.

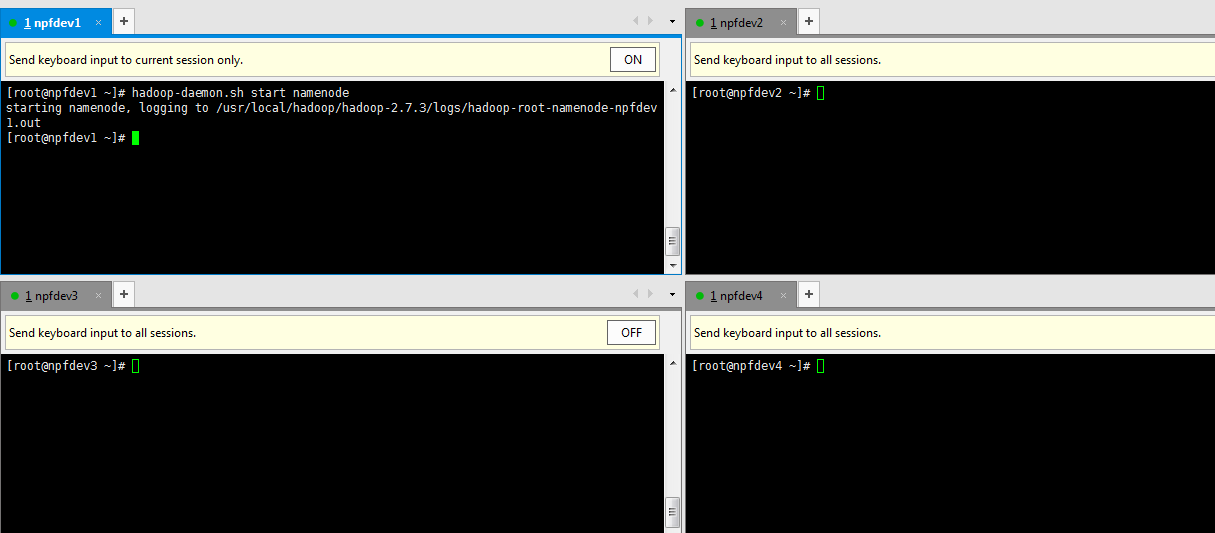

1. 首先在 npdev1 机器上面运行 hadoop-daemon.sh start namenode,启动 namenode.

2. 然后在 npfdev2,npfdev3,npfdev4 分别运行 hadoop-daemon.sh start datanode

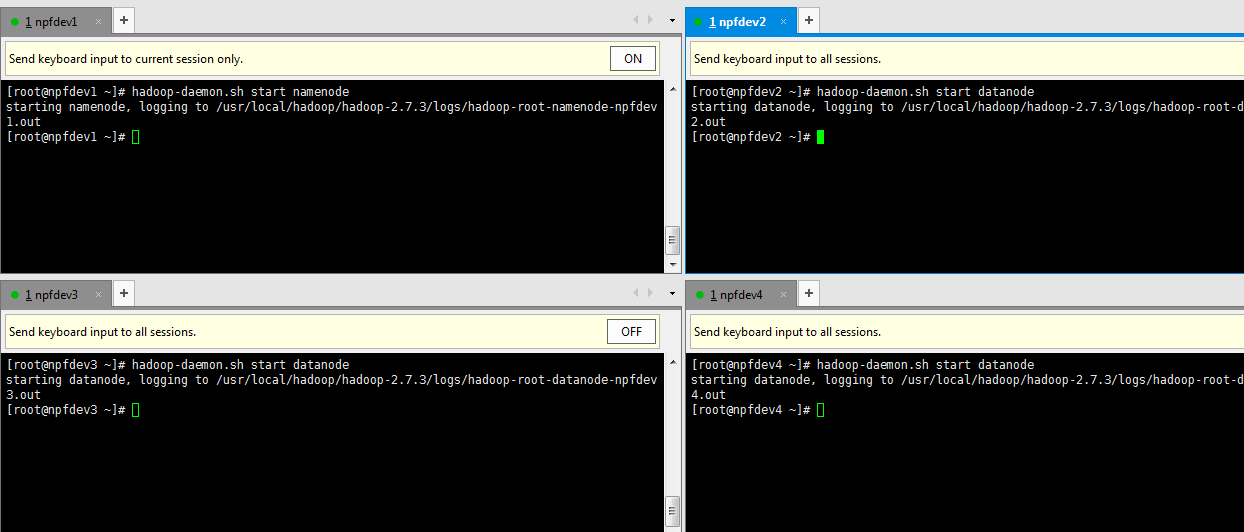

3. 启动完成之后,我们的 Hadoop 的物理架构和逻辑架构如下:

npfdev1 机器上面运行 namenode, npfdev2,npfdev3,npfdev4 分别运行 datanode.

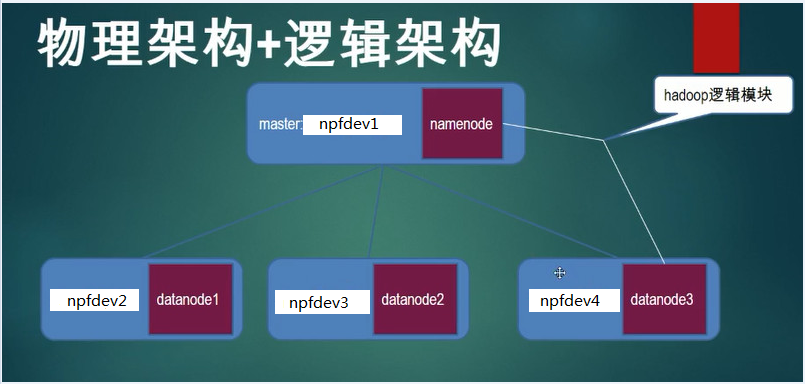

4. HDFS 架构如下:

Hadoop 简单来说就是多台机器备份的,可以横向扩展的系统。

二、使用命令行查看整个集群信息

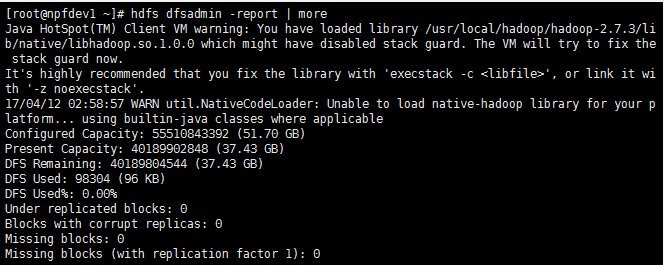

1. 使用 hdfs dfsadmin -report 命令

我们为了更好的展示,使用 hdfs dfsadmin -report | more 命令:

1.1 看集群的使用情况:

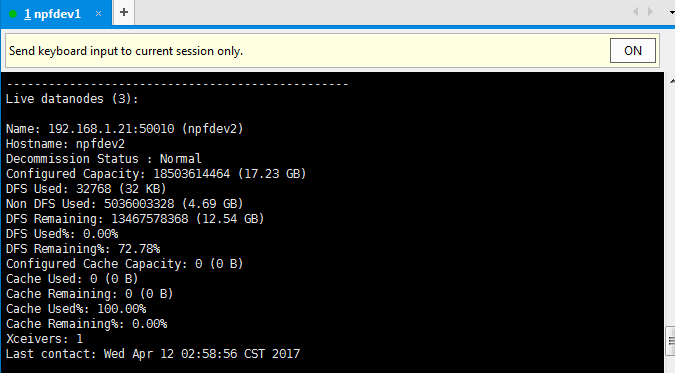

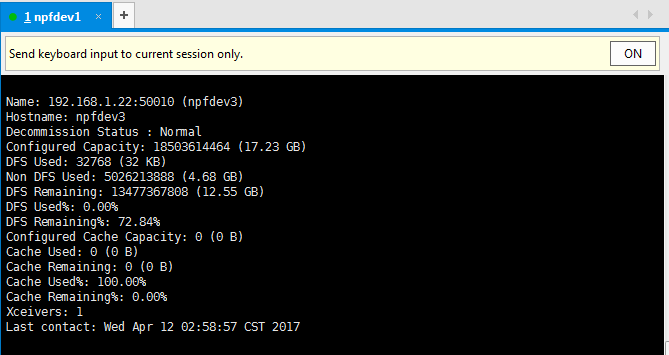

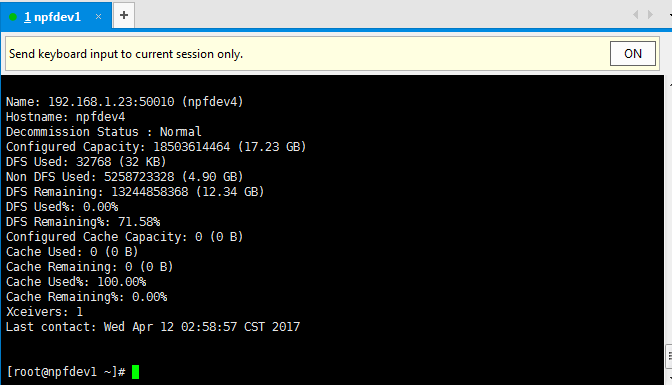

1.2 看集群的 datanode 的情况, 总共有 3 个 live 的 datanode.

第一个 datanode:

第二个 datanode:

第三个 datanode:

三、使用 web 页面查看整个集群信息

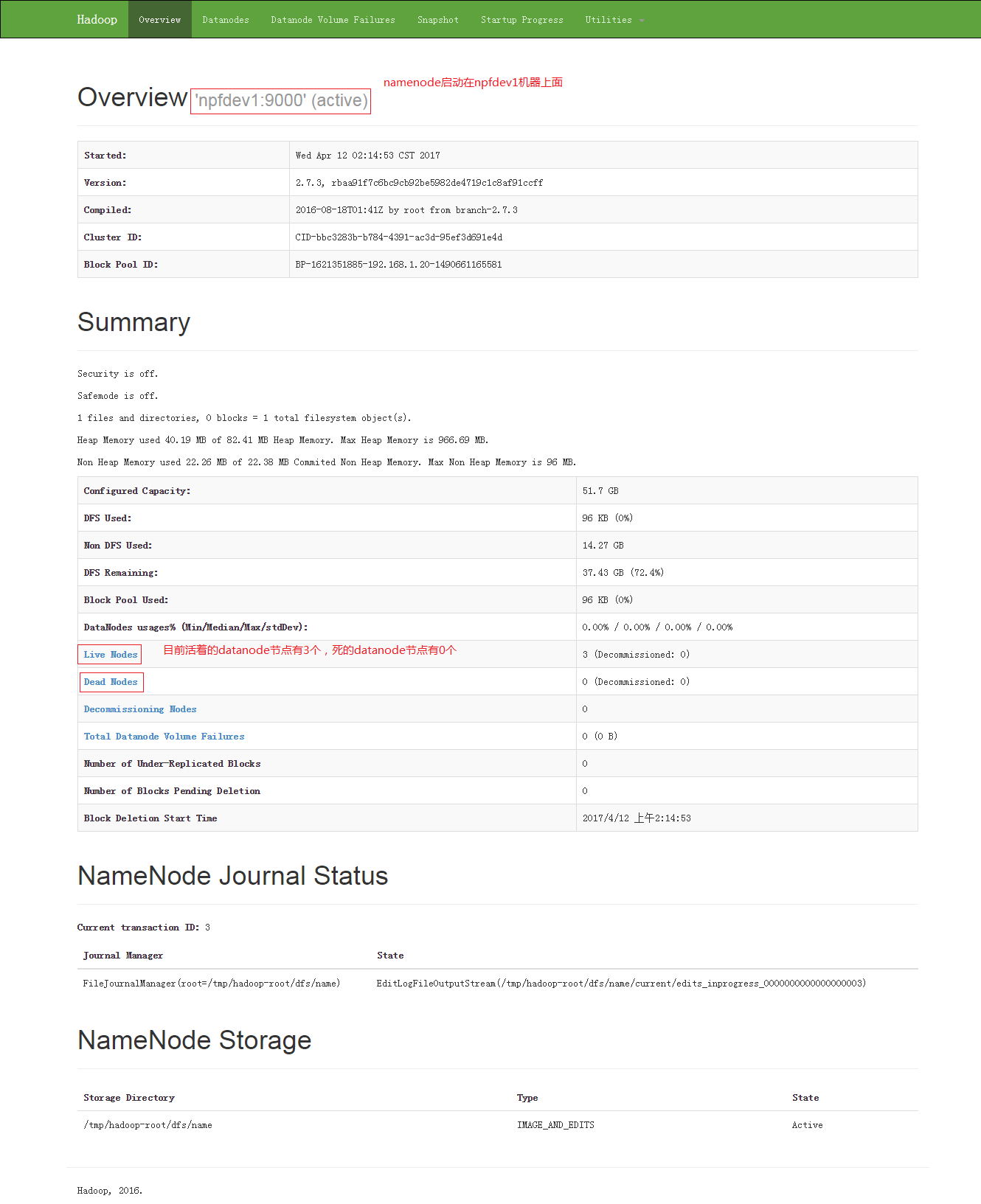

1. 访问 http://npfdev1:50070, 选择 Overview 选项:

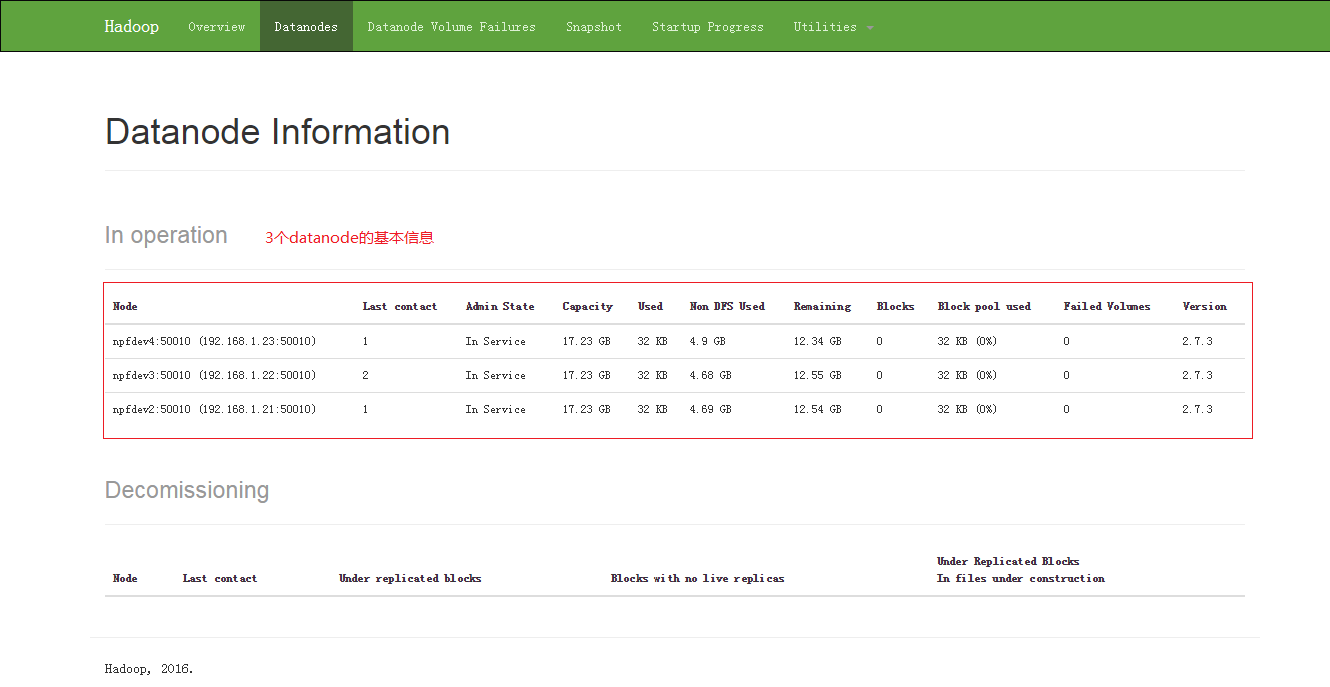

2. 选择 Datanodes 选项:

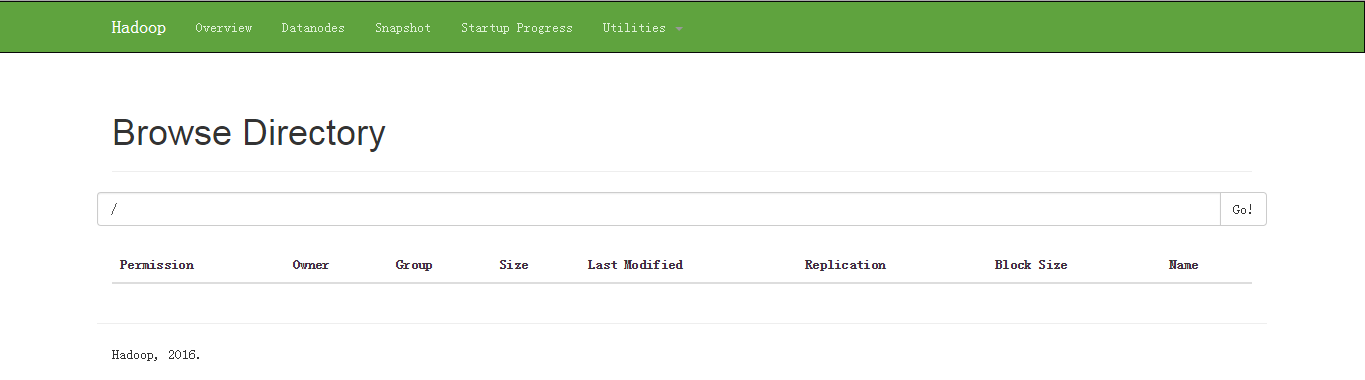

3. 选择 Utilities 选项下面的 browse directory, 可以看到整个硬盘的使用情况 :

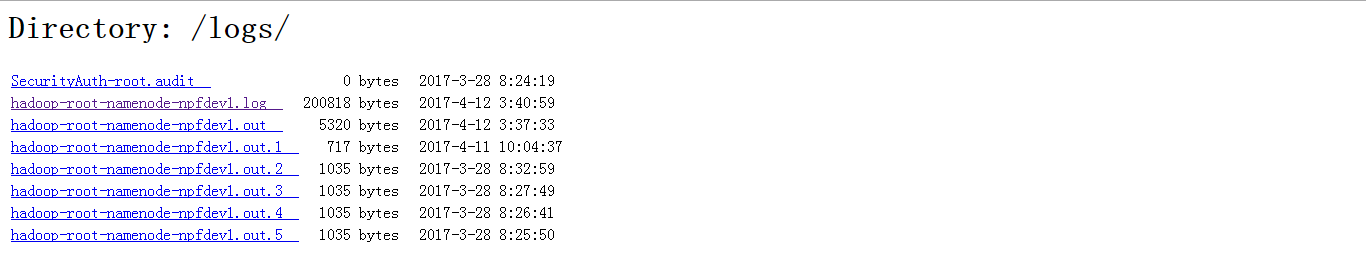

4. 选择 Utilities 选项下面的 logs, 可以看到启动日志:

四、关闭 Hadoop 集群

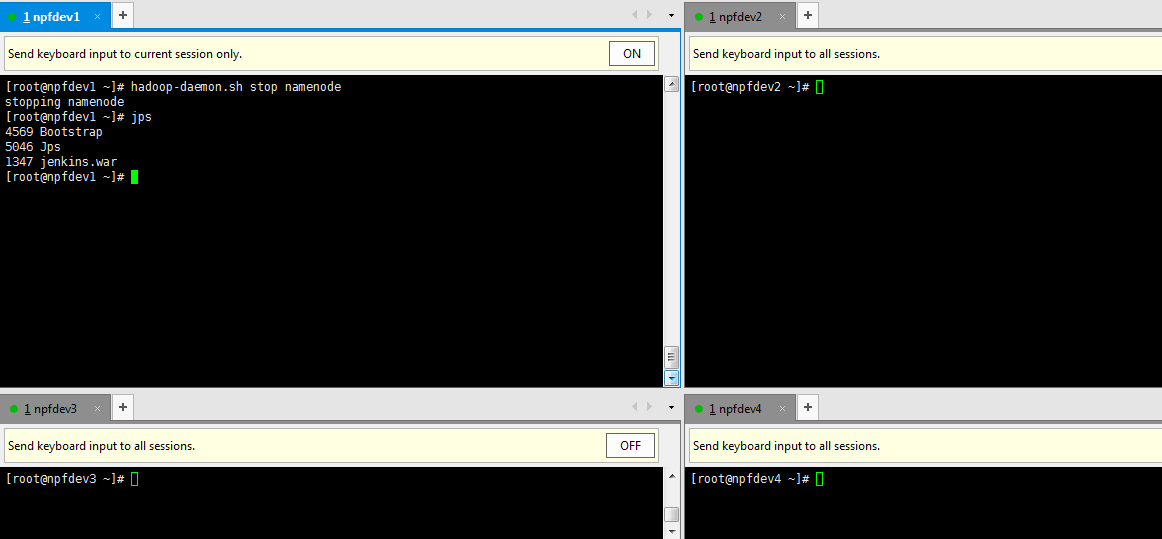

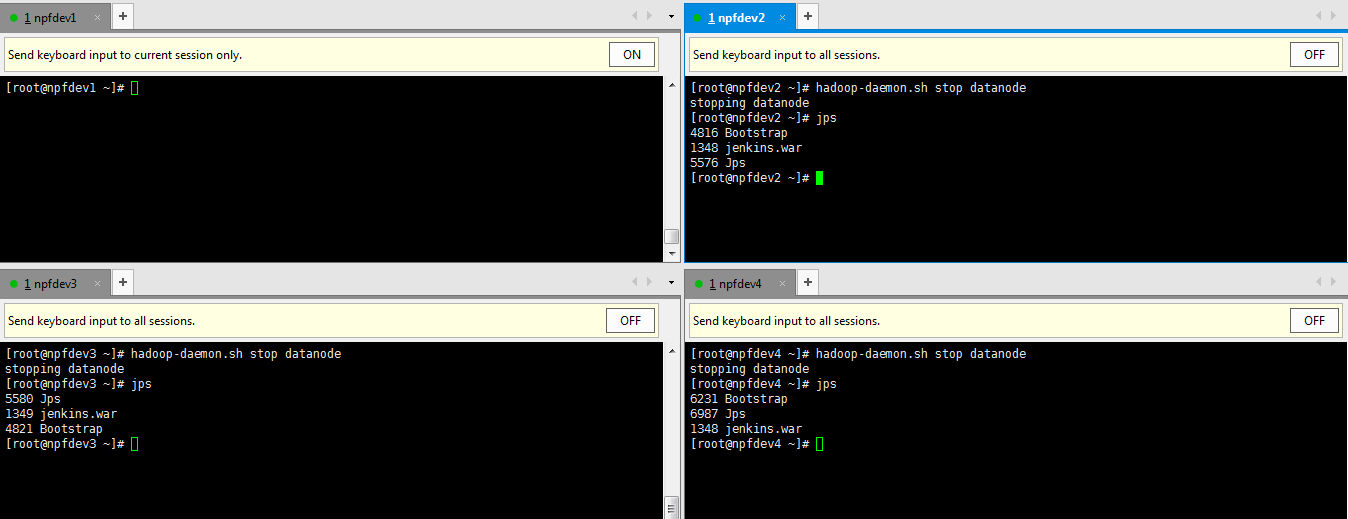

1. 首先在 npdev1 机器上面运行 hadoop-daemon.sh stop namenode.

2. 然后在 npfdev2,npfdev3,npfdev4 分别运行 hadoop-daemon.sh stop datanode.

五、启动和关闭 Hadoop 集群命令步骤总结:

1. 在 master 上启动 hadoop-daemon.sh start namenode.

2. 在 slave 上启动 hadoop-daemon.sh start datanode.

3. 用 jps 指令观察执行结果.

4. 用 hdfs dfsadmin -report 观察集群配置情况.

5. 通过 http://npfdev1:50070 界面观察集群运行情况.

6. 用 hadoop-daemon.sh stop … 手工关闭集群.

更多 Hadoop 相关信息见 Hadoop 专题页面 https://www.linuxidc.com/topicnews.aspx?tid=13

: