共计 5859 个字符,预计需要花费 15 分钟才能阅读完成。

Hadoop 集群环境的搭建和单机版的搭建差不多,就是多了一些文件的配置操作。

一、3 台主机的 hostname 修改和 IP 地址绑定

(1)3 太主机的基本网络环境

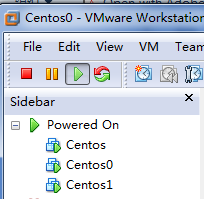

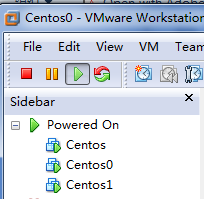

CentOS6.5,32 位,在虚拟机下实现。

我在虚拟机下安装了 3 个 centos6.5 系统,其 IP 地址和主机名分别如下:

192.168.1.103 hadoop

192.168.1.105 hadoop0

192.168.1.106 hadoop1

这里,hadoop 是 master,hadoop0 和 hadoop1 是两个 slaves。

(2)IP 地址与 hostname 绑定

在 hadoop 主机下:

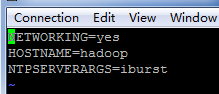

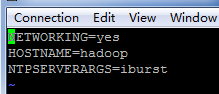

vi /etc/sysconfig/network

将 HOSTNAME 修改为 hadoop,见下图:

在 hadoop0 主机下操作类似,将 HOSTNAME 修改为 hadoop0;在 hadoop1 主机下操作类似,将 HOSTNAME 修改为 hadoop1。

在 hadoop 主机下:

输入:vi /etc/hosts,在 hosts 下添加如下内容:

192.168.1.103 hadoop

192.168.1.105 hadoop0

192.168.1.106 hadoop1

然后通过 scp 命令,将修改好的 hosts 复制到 hadoop0 和 hadoop1 的 /etc/hosts 文件夹下覆盖:

scp /etc/hosts root@hadoop0:/etc/hosts

scp /etc/hosts root@hadoop1:/etc/hosts

(3)测试 3 太主机之间是否能 Ping 通

在 3 台主机下分别输入:

ping hadoop

ping hadoop0

ping hadoop1

如果 3 太主机都能 ping 通,那说明前面的配置成功。

————————————– 分割线 ————————————–

Ubuntu 13.04 上搭建 Hadoop 环境 http://www.linuxidc.com/Linux/2013-06/86106.htm

Ubuntu 12.10 +Hadoop 1.2.1 版本集群配置 http://www.linuxidc.com/Linux/2013-09/90600.htm

Ubuntu 上搭建 Hadoop 环境(单机模式 + 伪分布模式)http://www.linuxidc.com/Linux/2013-01/77681.htm

Ubuntu 下 Hadoop 环境的配置 http://www.linuxidc.com/Linux/2012-11/74539.htm

单机版搭建 Hadoop 环境图文教程详解 http://www.linuxidc.com/Linux/2012-02/53927.htm

————————————– 分割线 ————————————–

二、SSH 免密码登陆

1. 查看当前用户下 (root) 是否有.ssh 的隐藏文件,如果没有就创建一个

mkdir .ssh

2. 输入 ssh-keygen -t rsa

这个命令会在.ssh 文件夹下生成 id_dsa 和 id_ds.pub 两个文件,这私钥和公钥。

3. 输入

cp id_rsa.pub authorized_keys

这条命令是把公钥加到用于认证的公钥文件中

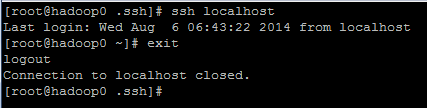

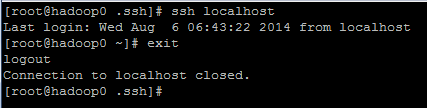

4. 验证 SSH 是否安装成功,以及是否可以免密码登陆本机

ssh localhost

如果显示如下,表示安装成功

5. 将 authorized_keys 复制到 hadoop0 和 hadoop1 下的.ssh 文件,这样就可以免密码登陆 hadoop0 和 hadoop1 了。

scp authorized_keys root@hadoop0:.ssh/

scp authorized_keys root@hadoop1:.ssh/

6. 测试

在 hadoop 主机下输入:

在第一次登陆是需要密码,以后则不要。到此,ssh 的免密码登陆完成。

更多详情见请继续阅读下一页的精彩内容:http://www.linuxidc.com/Linux/2014-08/105267p2.htm

三、jdk 的安装和 java 环境变量配置

(1)安装 jdk1.6

这里,我使用的 jdk 安装包如下,大家可以上网自行下载,这里推荐 jdk 为 1.6 为好。

在 Hadoop 下:

将 jdk 安装包移动到 /usr/local 这个目录下,(local 下的文件可以删除,没有用的)。

然后首先是给 jdk 安装包“X”的执行权限,chmod u+x jdk-6u24-linux-i586.bin。(如有 x 权限请忽略这一步)

然后就是执行安装即可,jdk-6u24-linux-i586.bin。

然后将 /usr/local 下 jdk 的文件夹从命名为 jdk。然后通过 scp 命令将 jdk 文件夹复制到另外两个 slaves 主机。

scp -r /etc/local/jdk root@hadoop0:/etc/local

scp -r /etc/local/jdk root@hadoop1:/etc/local

(2)设置环境变量

接下来就是配置环境变量:

vi /etc/profile

export JAVA_HOME=/usr/local/jdk

export PATH=.:$JAVA_HOME/bin:$PATH

输入 source /etc/profile 使配置文件生效。

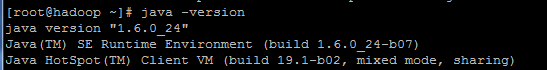

检查 jdk 是否安装配置成功,java -version,若显示如下,表示安装成功。

同样,将 profile 复制到另外两台主机。

scp /etc/profile root@hadoop0:/etc/

scp /etc/profile root@hadoop1:/etc/

在 hadoop0 和 hadoop1 下检查是否安装 jdk 成功。注意请先使用 source /etc/profile 更新命令。

如果现实如上图,则表示 3 台主机的 jdk 安装和配置成功。

四、安装和配置 hadoop

(1)解压安装 hadoop1.1.2

下载并将 hadoop-1.1.2.tar.gz 解压到当前用户目录下(/usr/local)。

tar -zxvf hadoop-1.1.2.tar.gz

然后将 hadoop 文件夹重命名为 hadoop。

(2)配置 hadoop

进入 hadoop 文件夹下的 conf 夹,修改配置文件。

1. 指定 jdk 安装位置:

Hadoop-env.sh:

export JAVA_HOME=/usr/local/jdk

2.hadoop 核心配置文件,配置 HDFS 地址和段口号。

core-site.xml

<configuration>

<property>

<name>fs.default.name</name>

<value>hdfs://hadoop:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/local/hadoop/tmp</value>

</property>

</configuration>

3.hdfs-site.xml,默认的配置方式是 3,这里表示副本数是 3,由于我们搭建的子节点只有 2 个,所以输入 1 或 2。

hdfs-site.xml

<configuration>

<property>

<name>dfs.replication</name>

<value>2</value>

</property>

</configuration>

4. 配置 MapReduce 文件,配置 JobTracker 的地址和端口

mapred-site.xml

<configuration>

<property>

<name>mapred.job.tracker</name>

<value>hadoop:9001</value>

</property>

</configuration>

5‘修改 masters 文件

hadoop

6. 修改 slaves 文件

hadoop0

hadoop1

然后将 hadoop 文件夹复制到另外 2 台主机。

scp /uer/local/hadoop root@hadoop0:/etc/local/

scp /uer/local/hadoop root@hadoop1:/etc/local/

接下来要修改环境变量:

vi /etc/profile

export JAVA_HOME=/usr/local/jdk

export HADOOP_HOME=/usr/local/hadoop

export PATH=.:$HADOOP_HOME/bin:$JAVA_HOME/bin:$PATH

同样,将 profile 复制到另外两台主机上,操作见三(2)。

(3)启动 hadoop

输入:

hadoop namenode -format

然后通过 start-all.sh 启动所有进程:

start-all.sh

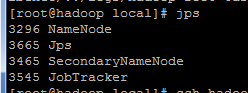

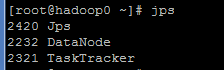

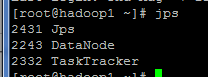

可以通过 jps 命令来查看运行的进程,如果成功运行,那么将会有 5 个进程运行,如下图:

在 hadoop 下:

在 hadoop0 下:

在 hadoop1 下:

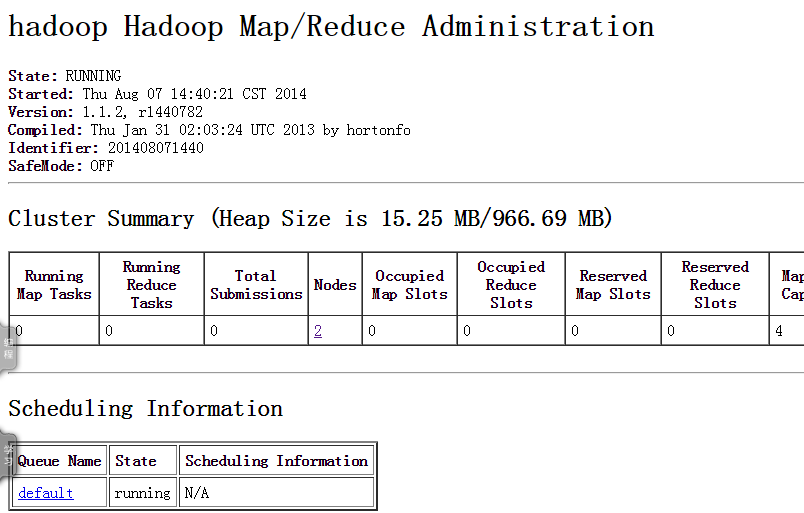

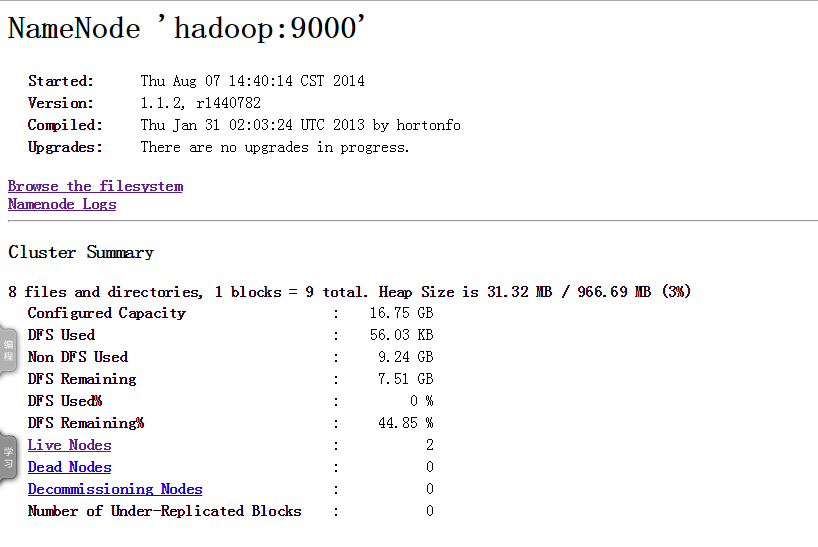

至此,hadoop 启动成功,要想看集群状态,可以打开下面两个网址:

localhost:50030(mapreduce 的 web 页面)

localhost:50070(HDFS 的 web 页面)

如果想在 windows 下访问这两个网址,那么就需要关闭 CentOS 的防火墙,否则访问不了。(3 台主机都要关闭防火墙)

命令:service iptables stop

使用:chkconfig iptables off,可以关闭防火墙的自动运行

备注:我也是刚起步学习 hadoop,可能文章有一些不完整或错误的地方,还请大家多多指教,也希望能交流学习,互相促进提高。

更多 Hadoop 相关信息见Hadoop 专题页面 http://www.linuxidc.com/topicnews.aspx?tid=13

Hadoop 集群环境的搭建和单机版的搭建差不多,就是多了一些文件的配置操作。

一、3 台主机的 hostname 修改和 IP 地址绑定

(1)3 太主机的基本网络环境

CentOS6.5,32 位,在虚拟机下实现。

我在虚拟机下安装了 3 个 centos6.5 系统,其 IP 地址和主机名分别如下:

192.168.1.103 hadoop

192.168.1.105 hadoop0

192.168.1.106 hadoop1

这里,hadoop 是 master,hadoop0 和 hadoop1 是两个 slaves。

(2)IP 地址与 hostname 绑定

在 hadoop 主机下:

vi /etc/sysconfig/network

将 HOSTNAME 修改为 hadoop,见下图:

在 hadoop0 主机下操作类似,将 HOSTNAME 修改为 hadoop0;在 hadoop1 主机下操作类似,将 HOSTNAME 修改为 hadoop1。

在 hadoop 主机下:

输入:vi /etc/hosts,在 hosts 下添加如下内容:

192.168.1.103 hadoop

192.168.1.105 hadoop0

192.168.1.106 hadoop1

然后通过 scp 命令,将修改好的 hosts 复制到 hadoop0 和 hadoop1 的 /etc/hosts 文件夹下覆盖:

scp /etc/hosts root@hadoop0:/etc/hosts

scp /etc/hosts root@hadoop1:/etc/hosts

(3)测试 3 太主机之间是否能 Ping 通

在 3 台主机下分别输入:

ping hadoop

ping hadoop0

ping hadoop1

如果 3 太主机都能 ping 通,那说明前面的配置成功。

————————————– 分割线 ————————————–

Ubuntu 13.04 上搭建 Hadoop 环境 http://www.linuxidc.com/Linux/2013-06/86106.htm

Ubuntu 12.10 +Hadoop 1.2.1 版本集群配置 http://www.linuxidc.com/Linux/2013-09/90600.htm

Ubuntu 上搭建 Hadoop 环境(单机模式 + 伪分布模式)http://www.linuxidc.com/Linux/2013-01/77681.htm

Ubuntu 下 Hadoop 环境的配置 http://www.linuxidc.com/Linux/2012-11/74539.htm

单机版搭建 Hadoop 环境图文教程详解 http://www.linuxidc.com/Linux/2012-02/53927.htm

————————————– 分割线 ————————————–

二、SSH 免密码登陆

1. 查看当前用户下 (root) 是否有.ssh 的隐藏文件,如果没有就创建一个

mkdir .ssh

2. 输入 ssh-keygen -t rsa

这个命令会在.ssh 文件夹下生成 id_dsa 和 id_ds.pub 两个文件,这私钥和公钥。

3. 输入

cp id_rsa.pub authorized_keys

这条命令是把公钥加到用于认证的公钥文件中

4. 验证 SSH 是否安装成功,以及是否可以免密码登陆本机

ssh localhost

如果显示如下,表示安装成功

5. 将 authorized_keys 复制到 hadoop0 和 hadoop1 下的.ssh 文件,这样就可以免密码登陆 hadoop0 和 hadoop1 了。

scp authorized_keys root@hadoop0:.ssh/

scp authorized_keys root@hadoop1:.ssh/

6. 测试

在 hadoop 主机下输入:

在第一次登陆是需要密码,以后则不要。到此,ssh 的免密码登陆完成。

更多详情见请继续阅读下一页的精彩内容:http://www.linuxidc.com/Linux/2014-08/105267p2.htm