共计 6937 个字符,预计需要花费 18 分钟才能阅读完成。

一、主机规划

3 台主机:1 个 master、2 个 slaver/worker

ip 地址使用 docker 默认的分配地址:

master:

主机名:Hadoop2、ip 地址:172.17.0.2

slaver1:

主机名:hadoop3、ip 地址:172.17.0.3

主机名:hadoop4、ip 地址:172.17.0.4

二、软件安装

1、在 docker 中安装 CentOS 镜像,并启动 centos 容器,安装 ssh。– 详见 ”docker 上安装 centos 镜像 ” 一文。

2、通过 ssh 连接到 centos 容器,安装 jdk1.8、hadoop3.0

可以按照传统 linux 安装软件的方法,通过将 jdk 和 hadoop 的 tar 包上传到主机进行安装。

获取 centos7 镜像

$ docker pull centos

大概是 70 多 M,使用阿里云等 Docker 加速器的话很快就能下载完,之后在镜像列表中就可以看到

查看镜像列表的命令:

$ docker images

安装 SSH

以 centos7 镜像为基础,构建一个带有 SSH 功能的 centos

$ vi Dockerfile

内容:

FROM centos

MAINTAINER linuxidc@linuxidc.com

RUN yum install -y openssh-server sudo

RUN sed -i ‘s/UsePAM yes/UsePAM no/g’ /etc/ssh/sshd_config

RUN yum install -y openssh-clients

RUN echo “root:abc123” | chpasswd

RUN echo “root ALL=(ALL) ALL” >> /etc/sudoers

RUN ssh-keygen -t dsa -f /etc/ssh/ssh_host_dsa_key

RUN ssh-keygen -t rsa -f /etc/ssh/ssh_host_rsa_key

RUN mkdir /var/run/sshd

EXPOSE 22

CMD [“/usr/sbin/sshd”, “-D”]

这段内容的大意是:以 centos 镜像为基础,安装 SSH 的相关包,设置了 root 用户的密码为 abc123,并启动 SSH 服务

执行构建镜像的命令,新镜像命名为 centos7-ssh

$ docker build -t=”centos7-ssh” .

执行完成后,可以在镜像列表中看到

$ docker images

构建 Hadoop 镜像

上面是运行了 3 个 centos 容器,需要在每个容器中单独安装 Hadoop 环境,我们可以像构建 SSH 镜像一样,构建一个 Hadoop 镜像,然后运行 3 个 Hadoop 容器,这样就更简单了

$ vi Dockerfile

内容:

FROM centos7-ssh

ADD jdk-8u151-linux-x64.tar.gz /usr/local/

RUN mv /usr/local/jdk1.8.0_151 /usr/local/jdk1.8

ENV Java_HOME /usr/local/jdk1.8

ENV PATH $JAVA_HOME/bin:$PATH

ADD hadoop-3.1.0.tar.gz /usr/local

RUN mv /usr/local/hadoop-3.1.0 /usr/local/hadoop

ENV HADOOP_HOME /usr/local/hadoop

ENV PATH $HADOOP_HOME/bin:$PATH

RUN yum install -y which sudo

这里是基于 centos7-ssh 这个镜像,把 JAVA 和 Hadoop 的环境都配置好了

前提:在 Dockerfile 所在目录下准备好 jdk-8u101-linux-x64.tar.gz 与 hadoop-2.7.3.tar.gz

执行构建命令,新镜像命名为 hadoop

$ docker build -t=”hadoop” .

在 /etc/hosts 文件中添加 3 台主机的主机名和 ip 地址对应信息

172.17.0.2 hadoop2

172.17.0.3 hadoop3

172.17.0.4 hadoop4

在 docker 中直接修改 /etc/hosts 文件,在重启容器后会被重置、覆盖。因此需要通过容器启动脚本 docker run 的 –add-host 参数将主机和 ip 地址的对应关系传入,容器在启动后会写入 hosts 文件中。如:

docker run –name hadoop2–add-host hadoop2:172.17.0.2 –add-host hadoop3:172.17.0.3 –add-host hadoop4:172.17.0.4 hadoop

docker exec -it hadoop2 bash

$ ssh-keygen -t rsa -P ” -f ~/.ssh/id_rsa

$ cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

$ chmod 0600 ~/.ssh/authorized_keys

hadoop 部署

1. 在 workers 文件中定义工作节点

在 hadoop 根目录下的 etc/hadoop 目录下新建 workers 文件,并添加工作节点主机信息。

按照步骤一中的主机规划,工作节点主机为 hadoop3 和 hadoop4 两台主机。如:

[root@9e4ede92e7db ~]# cat /usr/local/hadoop/etc/hadoop/workers

hadoop3

hadoop4

2、修改配置文件信息

a、在 hadoop-env.sh 中,添加 JAVA_HOME 信息

[root@9e4ede92e7db ~]# cat /usr/local/hadoop/etc/hadoop/hadoop-env.sh |grep JAVA_HOME

# JAVA_HOME=/usr/java/testing hdfs dfs -ls

# Technically, the only required environment variable is JAVA_HOME.

# export JAVA_HOME=

JAVA_HOME=/usr/local/jdk1.8

b、core-site.xml

configuration><property>

<name>fs.default.name</name>

<value>hdfs://hadoop2:9000</value>

</property>

<property>

<name>io.file.buffer.size</name>

<value>131072</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/home/hadoop/tmp</value>

<description>Abase for other temporary directories.</description>

</property>

</configuration>

c、hdfs-site.xml

<configuration>

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>hadoop2:9001</value>

<description># 通过 web 界面来查看 HDFS 状态 </description>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>/home/hadoop/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>/home/hadoop/dfs/data</value>

</property>

<property>

<name>dfs.replication</name>

<value>2</value>

<description># 每个 Block 有 2 个备份 </description>

</property>

<property>

<name>dfs.webhdfs.enabled</name>

<value>true</value>

</property>

</configuration>

d、yarn-site.xml

<configuration>

<!– Site specific YARN configuration properties –>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.aux-services.mapreduce.shuffle.class</name>

<value>org.apache.hadoop.mapred.ShuffleHandler</value>

</property>

<property>

<name>yarn.resourcemanager.address</name>

<value>hadoop2:8032</value>

</property>

<property>

<name>yarn.resourcemanager.scheduler.address</name>

<value>hadoop2:8030</value>

</property>

<property>

<name>yarn.resourcemanager.resource-tracker.address</name>

<value>hadoop2:8031</value>

</property>

<property>

<name>yarn.resourcemanager.admin.address</name>

<value>hadoop2:8033</value>

</property>

<property>

<name>yarn.resourcemanager.webapp.address</name>

<value>hadoop2:8088</value>

</property>

<property>

<name>yarn.nodemanager.resource.memory-mb</name>

<value>1024</value>

</property>

<property>

<name>yarn.nodemanager.resource.cpu-vcores</name>

<value>1</value>

</property>

</configuration>

e、mapred-site.xml

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapreduce.jobhistory.address</name>

<value>hadoop2:10020</value>

</property>

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>hadoop2:19888</value>

</property>

</configuration>

f、为防止进坑提前做好准备

vi start-dfs.sh vi stop-dfs.sh

HDFS_DATANODE_USER=root

#HADOOP_SECURE_DN_USER=hdfs

HDFS_NAMENODE_USER=root

HDFS_SECONDARYNAMENODE_USER=root

HDFS_DATANODE_SECURE_USER=hdfs

vi start-yarn.sh vi stop-yarn.sh

YARN_RESOURCEMANAGER_USER=root

HADOOP_SECURE_DN_USER=yarn

YARN_NODEMANAGER_USER=root

注意:

以上步骤完成以后停止当前容器,并使用 docker 命令保持到一个新的镜像。使用新的镜像重新启动集群,这样集群每台机器都有相同的账户、配置和软件,无需再重新配置。如:

a、停止容器

docker stop hadoop2

b、保存镜像

docker commit hadoop2 hadoop_me:v1.0

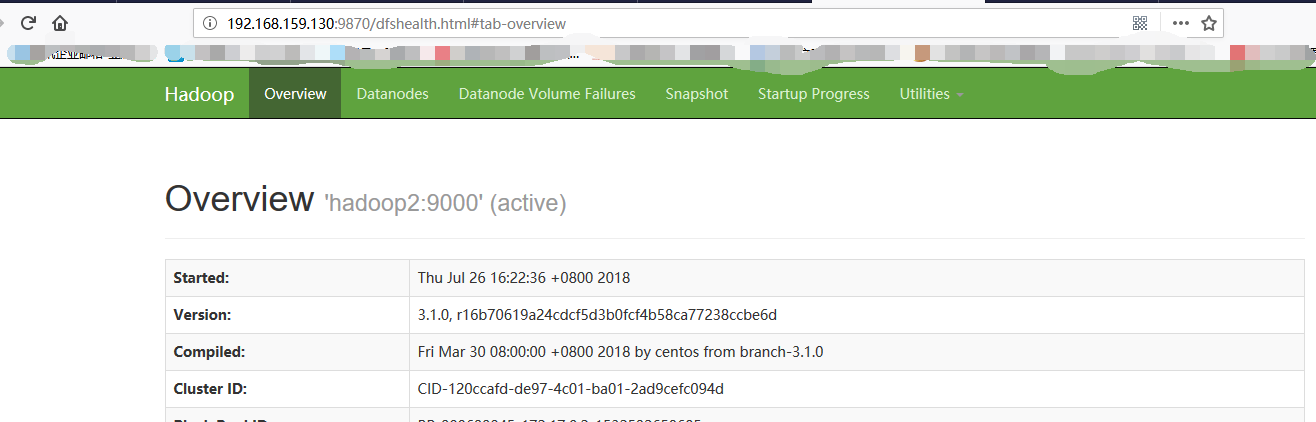

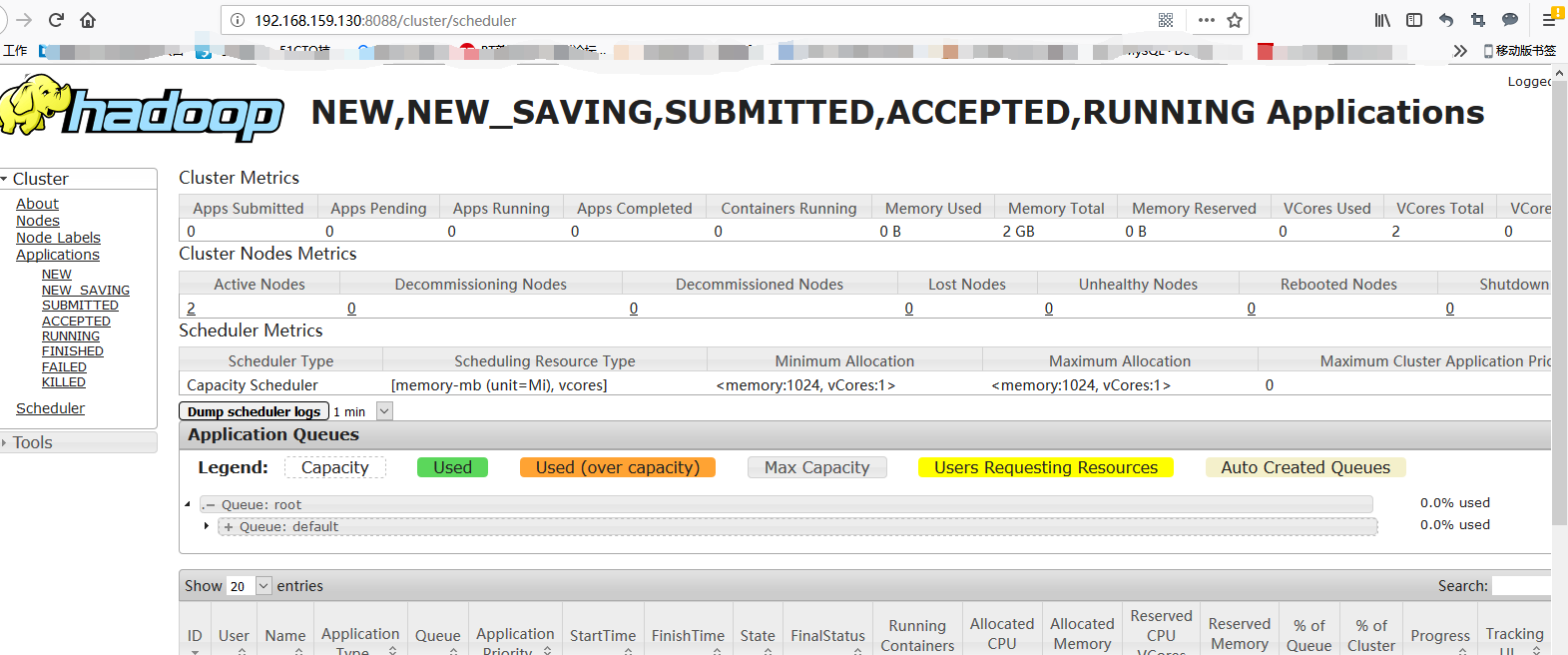

测试

1、端口映射

集群启动后,需要通过 web 界面观察集群的运行情况,因此需要将容器的端口映射到宿主主机的端口上,可以通过 docker run 命令的 - p 选项完成。比如:

将 yarn 任务调度端口映射到宿主主机 8088 端口上:

docker run -it -p 8088:8088 hadoop_me:v1.0

2、从新镜像启动 3 个容器

docker run –name hadoop2 –add-host hadoop2:172.17.0.2 –add-host hadoop3:172.17.0.3 –add-host hadoop4:172.17.0.4 -d -p 5002:22 -p 9870:9870 -p 8088:8088 -p 19888:19888

hadoop_me:v1.0

docker run –name hadoop3 –add-host hadoop2:172.17.0.2 –add-host hadoop3:172.17.0.3 –add-host hadoop4:172.17.0.4 -d -p 5003:22 hadoop_me:v1.0

docker run –name hadoop4 –add-host hadoop2:172.17.0.2 –add-host hadoop3:172.17.0.3 –add-host hadoop4:172.17.0.4 -d -p 5004:22 hadoop_me:v1.0

3. 格式化

进入到 /usr/local/hadoop 目录下

执行格式化命令

bin/hdfs namenode -format

修改 hadoop2 中 hadoop 的一个配置文件 etc/hadoop/slaves

删除原来的所有内容,修改为如下

hadoop3

hadoop4

在 hadoop2 中执行命令

scp -rq /usr/local/hadoop hadoop3:/usr/local

scp -rq /usr/local/hadoop hadoop4:/usr/local

4. 在 master 主机上执行 start-all.sh 脚本启动集群

5. 通过 web 页面访问

Hadoop2.3-HA 高可用集群环境搭建 https://www.linuxidc.com/Linux/2017-03/142155.htm

Hadoop 项目之基于 CentOS7 的 Cloudera 5.10.1(CDH)的安装部署 https://www.linuxidc.com/Linux/2017-04/143095.htm

CentOS 7.4 下 Hadoop 2.7.6 安装部署 https://www.linuxidc.com/Linux/2018-08/153353.htm

Hadoop2.7.2 集群搭建详解(高可用)https://www.linuxidc.com/Linux/2017-03/142052.htm

使用 Ambari 来部署 Hadoop 集群(搭建内网 HDP 源)https://www.linuxidc.com/Linux/2017-03/142136.htm

Ubuntu 14.04 下 Hadoop 集群安装 https://www.linuxidc.com/Linux/2017-02/140783.htm

CentOS 6.7 安装 Hadoop 2.7.2 https://www.linuxidc.com/Linux/2017-08/146232.htm

Ubuntu 16.04 上构建分布式 Hadoop-2.7.3 集群 https://www.linuxidc.com/Linux/2017-07/145503.htm

CentOS 7 下 Hadoop 2.6.4 分布式集群环境搭建 https://www.linuxidc.com/Linux/2017-06/144932.htm

Hadoop2.7.3+Spark2.1.0 完全分布式集群搭建过程 https://www.linuxidc.com/Linux/2017-06/144926.htm

CentOS 7.4 下编译安装 Hadoop 2.7.6 及所需文件 https://www.linuxidc.com/Linux/2018-06/152786.htm

Ubuntu 16.04.3 下安装配置 Hadoop https://www.linuxidc.com/Linux/2018-04/151993.htm

更多 Hadoop 相关信息见 Hadoop 专题页面 http://www.linuxidc.com/topicnews.aspx?tid=13

: