共计 13652 个字符,预计需要花费 35 分钟才能阅读完成。

Spark 是 Apache 公司推出的一种基于 Hadoop Distributed File System(HDFS)的并行计算架构。与 MapReduce 不同,Spark 并不局限于编写 map 和 reduce 两个方法,其提供了更为强大的内存计算 (in-memory computing) 模型,使得用户可以通过编程将数据读取到集群的内存当中,并且可以方便用户快速地重复查询,非常适合用于实现机器学习算法。本文将介绍 Apache Spark1.1.0 部署与开发环境搭建。

更多 Spark 相关教程见以下内容:

CentOS 7.0 下安装并配置 Spark http://www.linuxidc.com/Linux/2015-08/122284.htm

Spark1.0.0 部署指南 http://www.linuxidc.com/Linux/2014-07/104304.htm

CentOS 6.2(64 位)下安装 Spark0.8.0 详细记录 http://www.linuxidc.com/Linux/2014-06/102583.htm

Spark 简介及其在 Ubuntu 下的安装使用 http://www.linuxidc.com/Linux/2013-08/88606.htm

安装 Spark 集群(在 CentOS 上) http://www.linuxidc.com/Linux/2013-08/88599.htm

Hadoop vs Spark 性能对比 http://www.linuxidc.com/Linux/2013-08/88597.htm

Spark 安装与学习 http://www.linuxidc.com/Linux/2013-08/88596.htm

Spark 并行计算模型 http://www.linuxidc.com/Linux/2012-12/76490.htm

0. 准备

出于学习目的,本文将 Spark 部署在虚拟机中,虚拟机选择 VMware WorkStation。在虚拟机中,需要安装以下软件:

- Ubuntu 14.04.1 LTS 64 位桌面版

- hadoop-2.4.0.tar.gz

- jdk-7u67-linux-x64.tar.gz

- scala-2.10.4.tgz

- spark-1.1.0-bin-hadoop2.4.tgz

Spark 的开发环境,本文选择 Windows7 平台,IDE 选择 IntelliJ IDEA。在 Windows 中,需要安装以下软件:

- IntelliJ IDEA 13.1.4 Community Edition

- apache-maven-3.2.3-bin.zip(安装过程比较简单,请读者自行安装)

1. 安装 JDK

解压 jdk 安装包到 /usr/lib 目录:

1 sudo cp jdk-7u67-linux-x64.gz /usr/lib

2 cd /usr/lib

3 sudo tar -xvzf jdk-7u67-linux-x64.gz

4 sudo gedit /etc/profile在 /etc/profile 文件的末尾添加环境变量:

1 export JAVA_HOME=/usr/lib/jdk1.7.0_67

2 export JRE_HOME=/usr/lib/jdk1.7.0_67/jre

3 export PATH=$JAVA_HOME/bin:$JRE_HOME/bin:$PATH

4 export CLASSPATH=.:$JAVA_HOME/lib:$JRE_HOME/lib:$CLASSPATH保存并更新 /etc/profile:

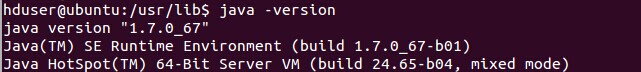

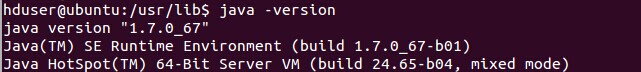

1 source /etc/profile测试 jdk 是否安装成功:

1 java -version

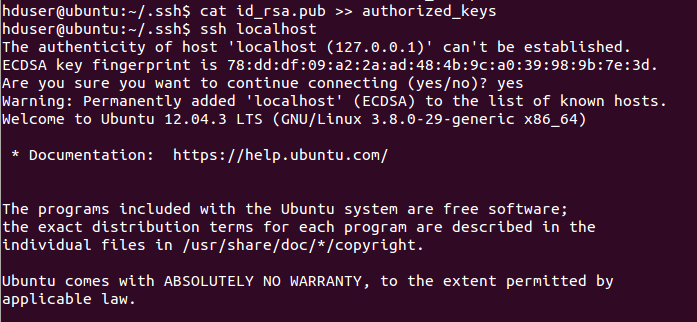

2. 安装及配置 SSH

1 sudo apt-get update

2 sudo apt-get install openssh-server

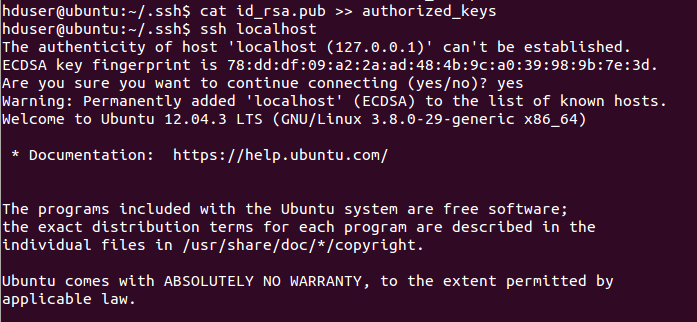

3 sudo /etc/init.d/ssh start生成并添加密钥:

1 ssh-keygen -t rsa -P ""

2 cd /home/hduser/.ssh

3 cat id_rsa.pub >> authorized_keysssh 登录:

1 ssh localhost

3. 安装 hadoop2.4.0

采用伪分布模式安装 hadoop2.4.0。解压 hadoop2.4.0 到 /usr/local 目录:

1 sudo cp hadoop-2.4.0.tar.gz /usr/local/

2 sudo tar -xzvf hadoop-2.4.0.tar.gz在 /etc/profile 文件的末尾添加环境变量:

1 export HADOOP_HOME=/usr/local/hadoop-2.4.0

2 export PATH=$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$PATH

3

4 export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native

5 export HADOOP_OPTS="-Djava.library.path=$HADOOP_HOME/lib"保存并更新 /etc/profile:

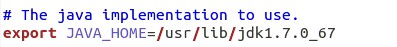

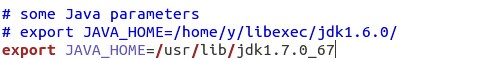

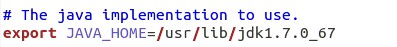

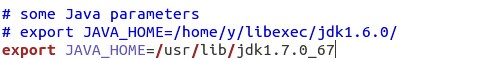

1 source /etc/profile在位于 /usr/local/hadoop-2.4.0/etc/hadoop 的 hadoop-env.sh 和 yarn-env.sh 文件中修改 jdk 路径:

1 cd /usr/local/hadoop-2.4.0/etc/hadoop

2 sudo gedit hadoop-env.sh

3 sudo gedit yarn-evn.shhadoop-env.sh:

yarn-env.sh:

修改 core-site.xml:

1 sudo gedit core-site.xml在 <configuration></configuration> 之间添加:

1 <property>

2 <name>fs.default.name</name>

3 <value>hdfs://localhost:9000</value>

4 </property>

5

6 <property>

7 <name>hadoop.tmp.dir</name>

8 <value>/app/hadoop/tmp</value>

9 </property>修改 hdfs-site.xml:

1 sudo gedit hdfs-site.xml在 <configuration></configuration> 之间添加:

修改 yarn-site.xml:

1 sudo gedit yarn-site.xml在 <configuration></configuration> 之间添加:

1 <property>

2 <name>mapreduce.framework.name</name>

3 <value>yarn</value>

4 </property>

5

6 <property>

7 <name>yarn.nodemanager.aux-services</name>

8 <value>mapreduce_shuffle</value>

9 </property>复制并重命名 mapred-site.xml.template 为 mapred-site.xml:

1 sudo cp mapred-site.xml.template mapred-site.xml

2 sudo gedit mapred-site.xml在 <configuration></configuration> 之间添加:

1 <property>

2 <name>mapreduce.jobtracker.address </name>

3 <value>hdfs://localhost:9001</value>

4 </property>在启动 hadoop 之前,为防止可能出现无法写入 log 的问题,记得为 /app 目录设置权限:

1 sudo mkdir /app

2 sudo chmod -R hduser:hduser /app格式化 hadoop:

1 hadoop namenode -format启动 hdfs 和 yarn。在开发 Spark 时,仅需要启动 hdfs:

1 sbin/start-dfs.sh

2 sbin/start-yarn.sh在浏览器中打开地址 http://localhost:50070/ 可以查看 hdfs 状态信息:

4. 安装 scala

1 sudo cp /home/hduser/Download/scala-2.9.3.tgz /usr/local

2 sudo tar -xvzf scala-2.9.3.tgz在 /etc/profile 文件的末尾添加环境变量:

1 export SCALA_HOME=/usr/local/scala-2.9.3

2 export PATH=$SCALA_HOME/bin:$PATH保存并更新 /etc/profile:

1 source /etc/profile测试 scala 是否安装成功:

1 scala -version

5. 安装 Spark

1 sudo cp spark-1.1.0-bin-hadoop2.4.tgz /usr/local

2 sudo tar -xvzf spark-1.1.0-bin-hadoop2.4.tgz在 /etc/profile 文件的末尾添加环境变量:

1 export SPARK_HOME=/usr/local/spark-1.1.0-bin-hadoop2.4

2 export PATH=$SPARK_HOME/bin:$PATH保存并更新 /etc/profile:

1 source /etc/profile复制并重命名 spark-env.sh.template 为 spark-env.sh:

1 sudo cp spark-env.sh.template spark-env.sh

2 sudo gedit spark-env.sh在 spark-env.sh 中添加:

1 export SCALA_HOME=/usr/local/scala-2.9.3

2 export JAVA_HOME=/usr/lib/jdk1.7.0_67

3 export SPARK_MASTER_IP=localhost

4 export SPARK_WORKER_MEMORY=1000m启动 Spark:

1 cd /usr/local/spark-1.1.0-bin-hadoop2.4

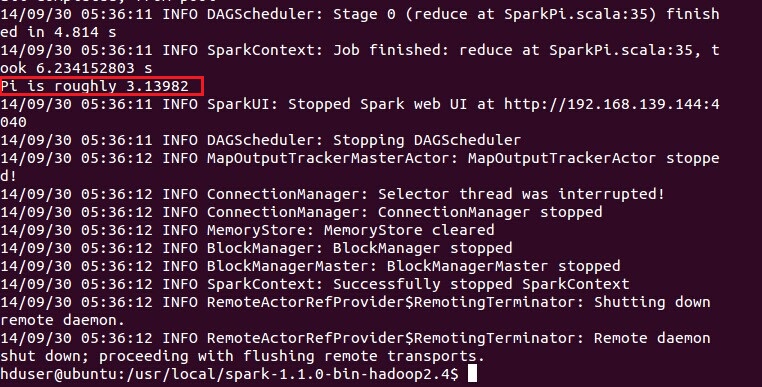

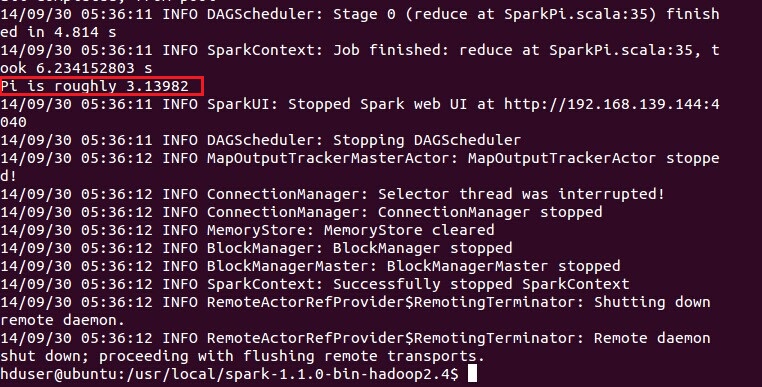

2 sbin/start-all.sh测试 Spark 是否安装成功:

1 cd /usr/local/spark-1.1.0-bin-hadoop2.4

2 bin/run-example SparkPi

6. 搭建 Spark 开发环境

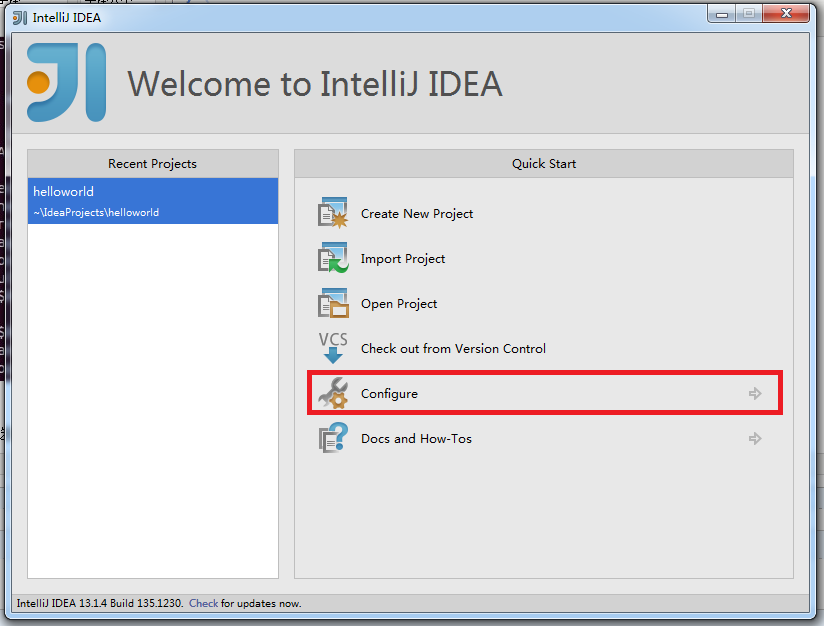

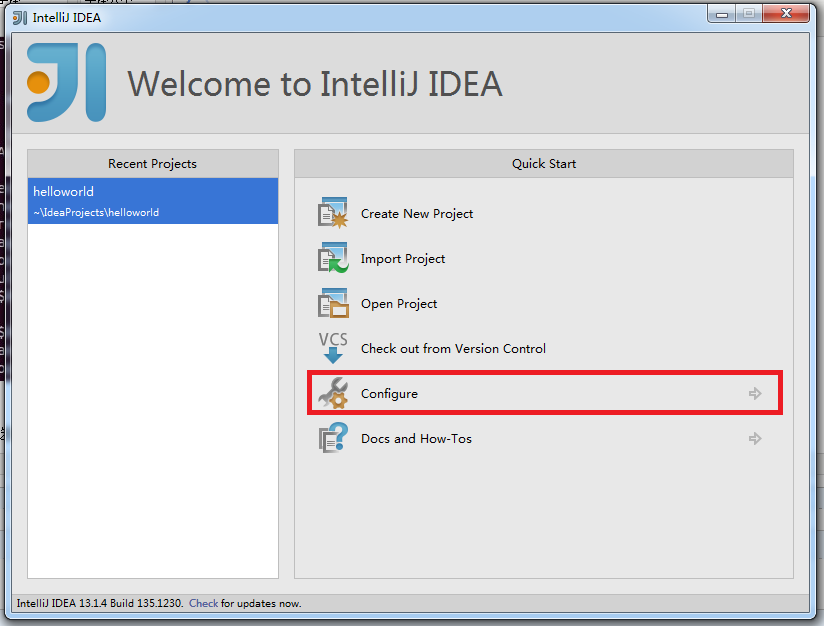

本文开发 Spark 的 IDE 推荐 IntelliJ IDEA,当然也可以选择 Eclipse。在使用 IntelliJ IDEA 之前,需要安装 scala 的插件。点击 Configure:

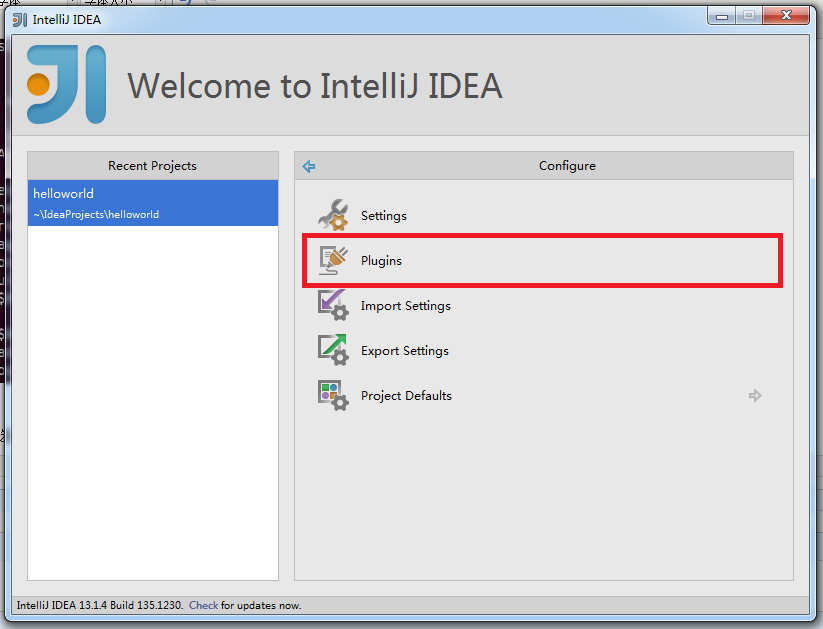

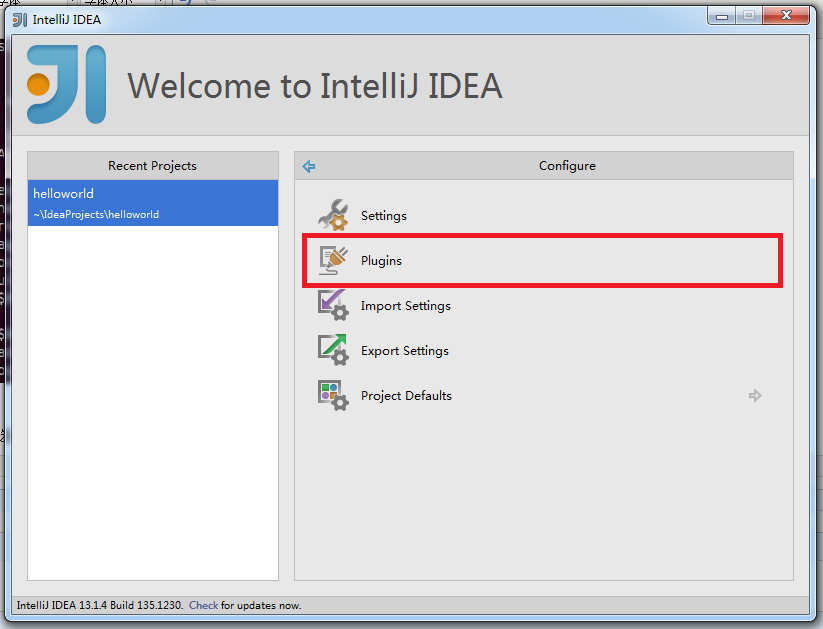

点击 Plugins:

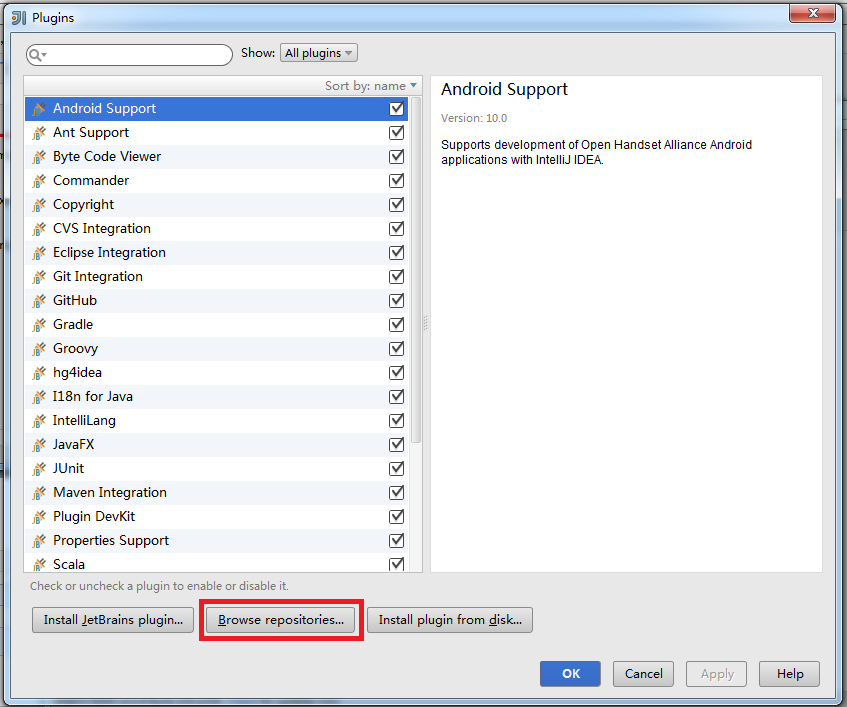

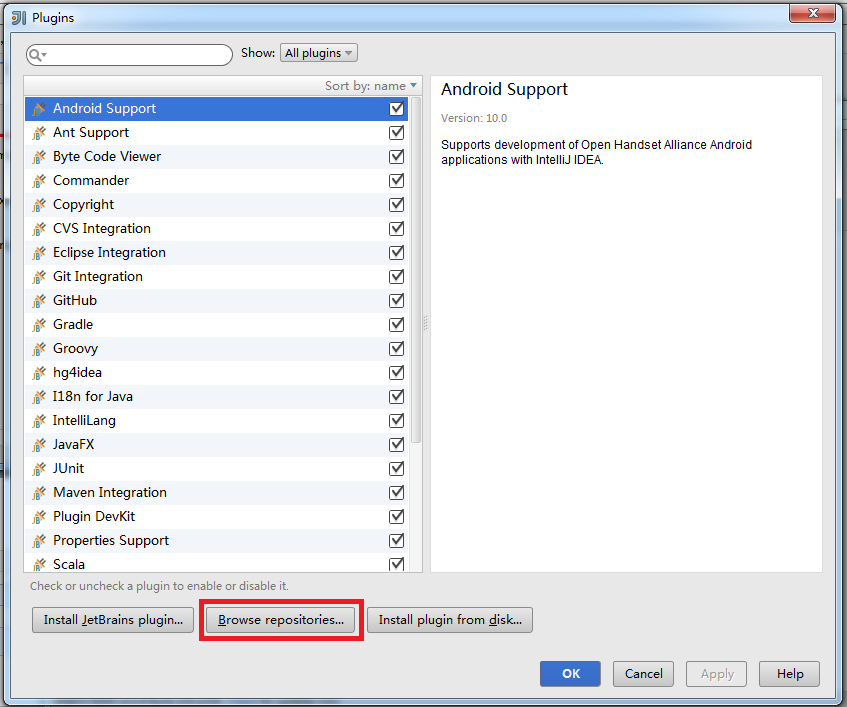

点击 Browse repositories…:

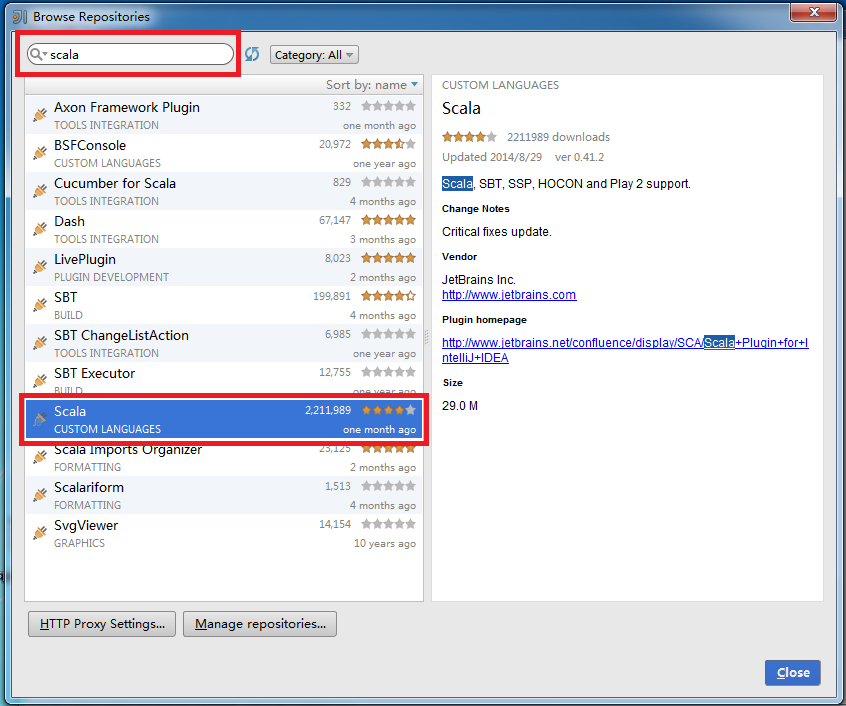

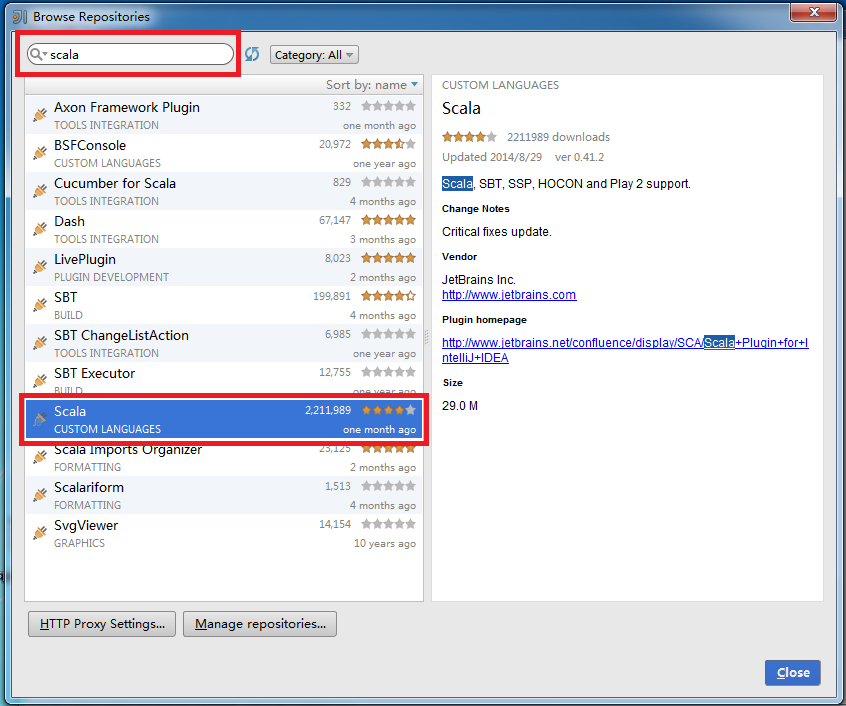

在搜索框内输入 scala,选择 Scala 插件进行安装。由于已经安装了这个插件,下图没有显示安装选项:

安装完成后,IntelliJ IDEA 会要求重启。

更多详情见请继续阅读下一页的精彩内容:http://www.linuxidc.com/Linux/2016-01/127856p2.htm

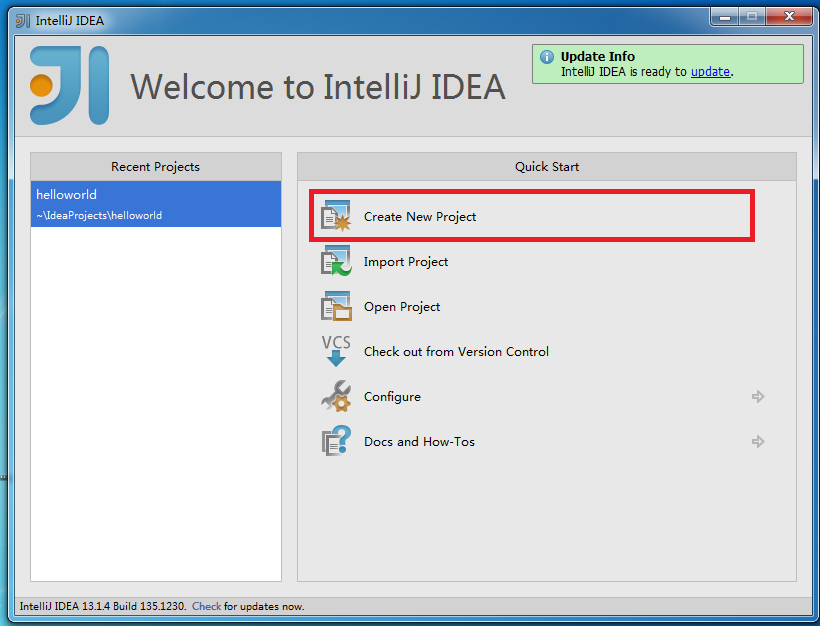

重启后,点击 Create New Project:

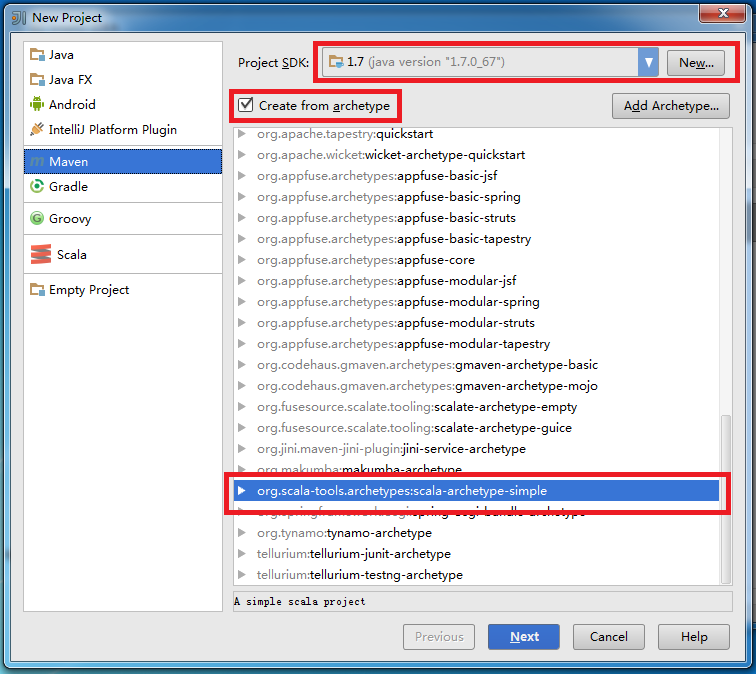

Project SDK 选择 jdk 安装目录,建议开发环境中的 jdk 版本与 Spark 集群上的 jdk 版本保持一致。点击左侧的 Maven,勾选 Create from archetype,选择 org.scala-tools.archetypes:scala-archetype-simple:

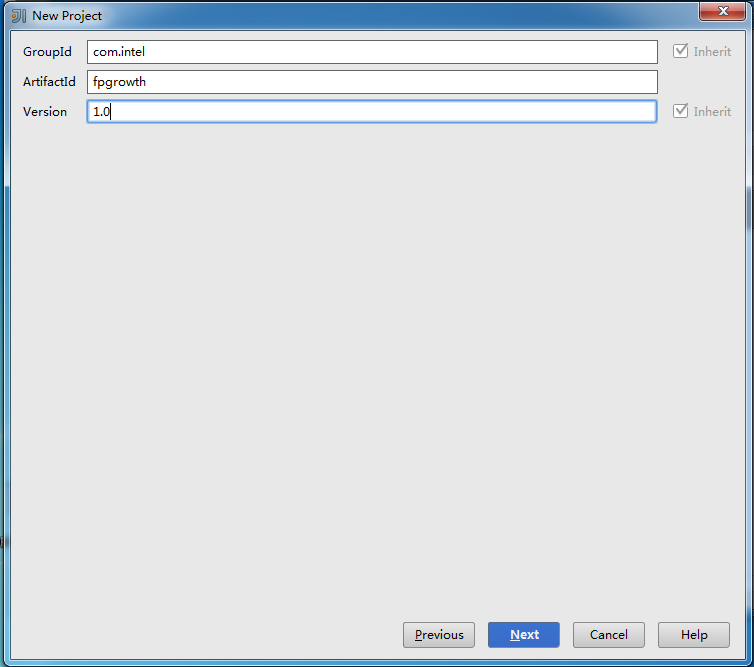

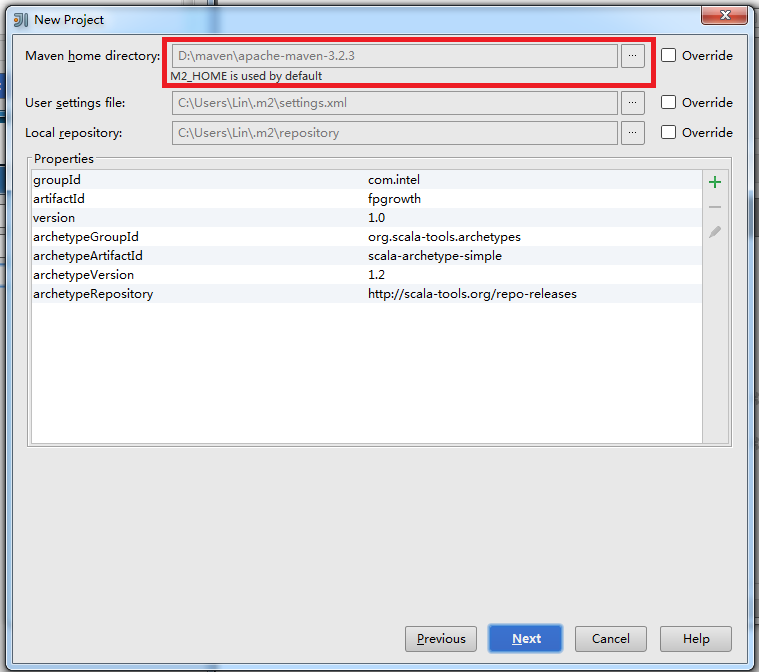

点击 Next 后,可根据需求自行填写 GroupId,ArtifactId 和 Version:

点击 Next 后,如果本机没有安装 maven 会报错,请保证之前已经安装 maven:

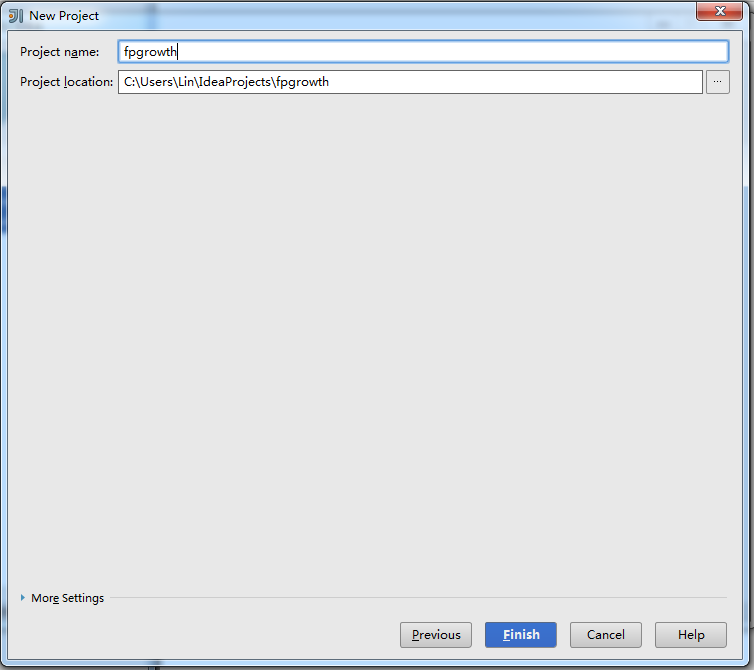

点击 Next 后,输入文件名,完成 New Project 的最后一步:

点击 Finish 后,maven 会自动生成 pom.xml 和下载依赖包。我们需要修改 pom.xml 中 scala 的版本:

1 <properties>

2 <scala.version>2.10.4</scala.version>

3 </properties>在 <dependencies></dependencies> 之间添加配置:

1 <!-- Spark -->

2 <dependency>

3 <groupId>org.apache.spark</groupId>

4 <artifactId>spark-core_2.10</artifactId>

5 <version>1.1.0</version>

6 </dependency>

7

8 <!-- HDFS -->

9 <dependency>

10 <groupId>org.apache.Hadoop</groupId>

11 <artifactId>hadoop-client</artifactId>

12 <version>2.4.0</version>

13 </dependency>在 <build><plugins></plugins></build> 之间添加配置:

1 <plugin>

2 <groupId>org.apache.maven.plugins</groupId>

3 <artifactId>maven-shade-plugin</artifactId>

4 <version>2.2</version>

5 <executions>

6 <execution>

7 <phase>package</phase>

8 <goals>

9 <goal>shade</goal>

10 </goals>

11 <configuration>

12 <filters>

13 <filter>

14 <artifact>*:*</artifact>

15 <excludes>

16 <exclude>META-INF/*SF</exclude>

17 <exclude>META-INF/*.DSA</exclude>

18 <exclude>META-INF/*.RSA</exclude>

19 </excludes>

20 </filter>

21 </filters>

22 <transformers>

23 <transformer

24 implementation="org.apache.maven.plugins.shade.resource.ManifestResourceTransformer">

25 <mainClass>mark.lin.App</mainClass> // 记得修改成你的 mainClass

26 </transformer>

27 <transformer

28 implementation="org.apache.maven.plugins.shade.resource.AppendingTransformer">

29 <resource>reference.conf</resource>

30 </transformer>

31 </transformers>

32 <shadedArtifactAttached>true</shadedArtifactAttached>

33 <shadedClassifierName>executable</shadedClassifierName>

34 </configuration>

35 </execution>

36 </executions>

37 </plugin>Spark 的开发环境至此搭建完成。One more thing,wordcount 的示例代码:

1 package mark.lin //别忘了修改 package

2

3 import org.apache.spark.{SparkConf, SparkContext}

4 import org.apache.spark.SparkContext._

5

6 import scala.collection.mutable.ListBuffer

7

8 /**

9 * Hello world!

10 *

11 */

12 object App{13 def main(args: Array[String]) {14 if (args.length != 1) {15 println("Usage: java -jar code.jar dependencies.jar")

16 System.exit(0)

17 }

18 val jars = ListBuffer[String]()

19 args(0).split(",").map(jars += _)

20

21 val conf = new SparkConf()

22 conf.setMaster("spark://localhost:7077").setAppName("wordcount").set("spark.executor.memory", "128m").setJars(jars)

23

24 val sc = new SparkContext(conf)

25

26 val file = sc.textFile("hdfs://localhost:9000/hduser/wordcount/input/input.csv")

27 val count = file.flatMap(line => line.split(" ")).map(word => (word, 1)).reduceByKey(_+_)

28 println(count)

29 count.saveAsTextFile("hdfs://localhost:9000/hduser/wordcount/output/")

30 sc.stop()

31 }

32 } 7. 编译 & 运行

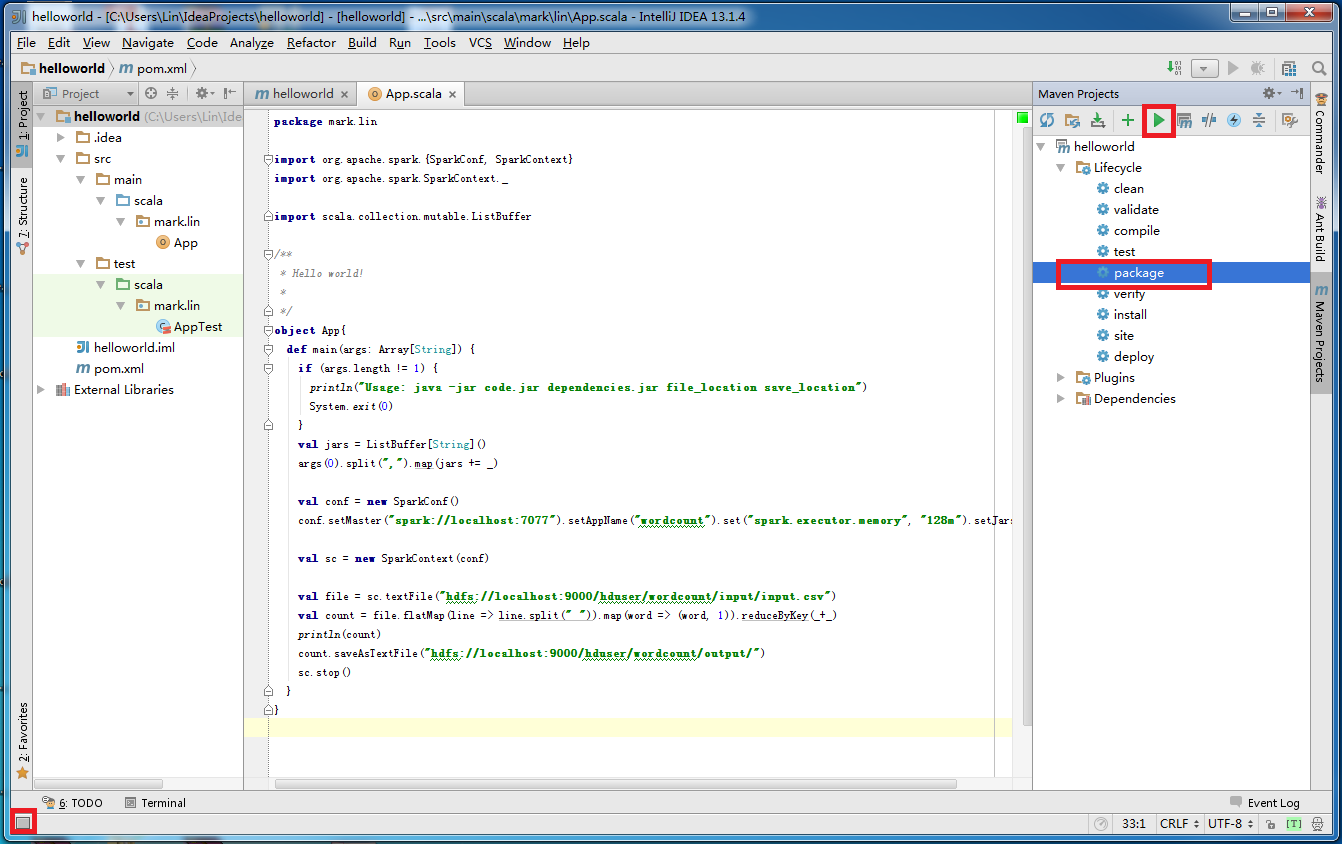

使用 maven 编译源代码。点击左下角,点击右侧 package,点击绿色三角形,开始编译。

在 target 目录下,可以看到 maven 生成的 jar 包。其中,hellworld-1.0-SNAPSHOT-executable.jar 是我们需要放到 Spark 集群上运行的。

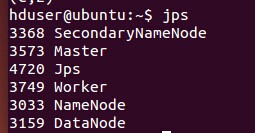

在运行 jar 包之前,保证 hadoop 和 Spark 处于运行状态:

将 jar 包拷贝到 Ubuntu 的本地文件系统上,输入以下命令运行 jar 包:

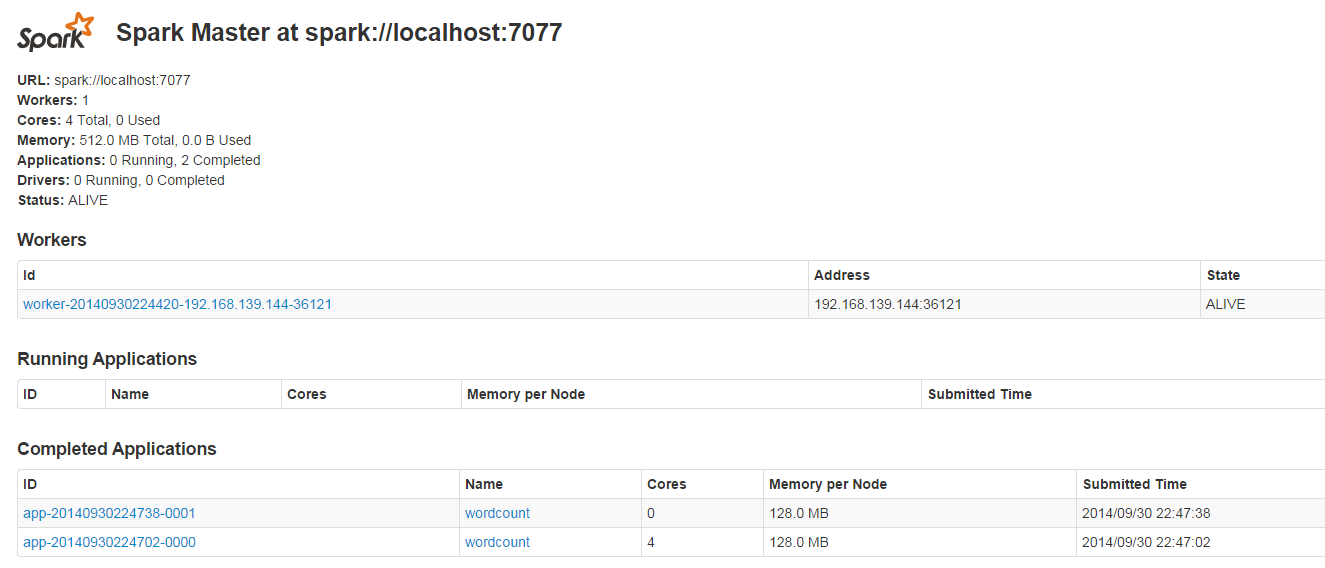

1 java -jar helloworld-1.0-SNAPSHOT-executable.jar helloworld-1.0-SNAPSHOT-executable.jar在浏览器中输入地址 http://localhost:8080/ 可以查看任务运行情况:

8. Q&A

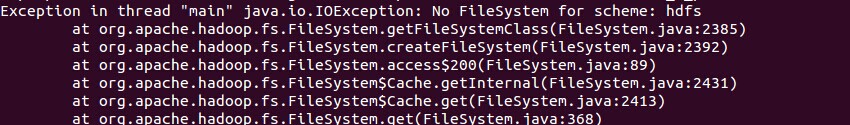

Q:在 Spark 集群上运行 jar 包,抛出异常“No FileSystem for scheme: hdfs”:

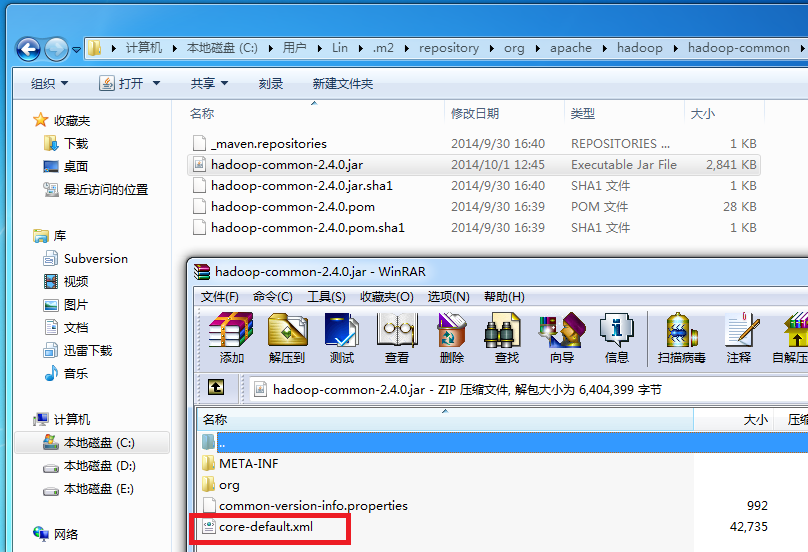

A:这是由于 hadoop-common-2.4.0.jar 中的 core-default.xml 缺少 hfds 的相关配置属性引起的异常。在 maven 仓库目录下找到hadoop-common-2.4.0.jar,以 rar 的打开方式打开:

将 core-default.xml 拖出,并添加配置:

1 <property>

2 <name>fs.hdfs.impl</name>

3 <value>org.apache.hadoop.hdfs.DistributedFileSystem</value>

4 <description>The FileSystem for hdfs: uris.</description>

5 </property>再将修改后的 core-default.xml 替换 hadoop-common-2.4.0.jar 中的 core-default.xml,重新编译生成 jar 包。

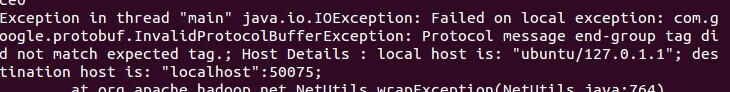

Q:在 Spark 集群上运行 jar 包,抛出异常“Failed on local exception”:

A:检查你的代码,一般是由于 hdfs 路径错误引起。

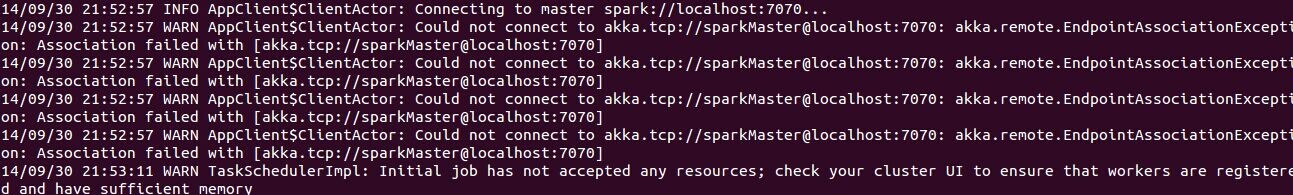

Q:在 Spark 集群上运行 jar 包,重复提示“Connecting to master spark”:

A: 检查你的代码,一般是由于 setMaster 路径错误引起。

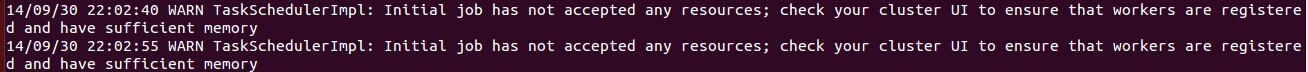

Q:在 Spark 集群上运行 jar 包,重复提示“Initial job has not accepted any resource; check your cluster UI to ensure that workers are registered and have sufficient memory”:

A:检查你的代码,一般是由于内存设置不合理引起。此外,还需要检查 Spark 安装目录下的 conf/spark-env.sh 对 worker 内存的设置。

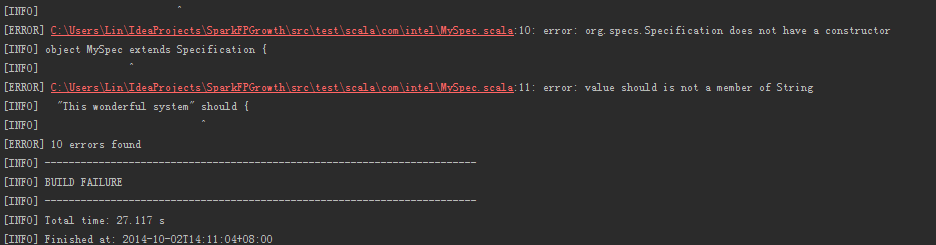

Q:maven 报错:error: org.specs.Specification does not have a constructor

A: 删除 test 目录下的文件,重新编译。

9. 参考资料

[1] Spark Documentation from Apache. [Link]

Spark 的详细介绍:请点这里

Spark 的下载地址:请点这里

本文永久更新链接地址:http://www.linuxidc.com/Linux/2016-01/127856.htm

Spark 是 Apache 公司推出的一种基于 Hadoop Distributed File System(HDFS)的并行计算架构。与 MapReduce 不同,Spark 并不局限于编写 map 和 reduce 两个方法,其提供了更为强大的内存计算 (in-memory computing) 模型,使得用户可以通过编程将数据读取到集群的内存当中,并且可以方便用户快速地重复查询,非常适合用于实现机器学习算法。本文将介绍 Apache Spark1.1.0 部署与开发环境搭建。

更多 Spark 相关教程见以下内容:

CentOS 7.0 下安装并配置 Spark http://www.linuxidc.com/Linux/2015-08/122284.htm

Spark1.0.0 部署指南 http://www.linuxidc.com/Linux/2014-07/104304.htm

CentOS 6.2(64 位)下安装 Spark0.8.0 详细记录 http://www.linuxidc.com/Linux/2014-06/102583.htm

Spark 简介及其在 Ubuntu 下的安装使用 http://www.linuxidc.com/Linux/2013-08/88606.htm

安装 Spark 集群(在 CentOS 上) http://www.linuxidc.com/Linux/2013-08/88599.htm

Hadoop vs Spark 性能对比 http://www.linuxidc.com/Linux/2013-08/88597.htm

Spark 安装与学习 http://www.linuxidc.com/Linux/2013-08/88596.htm

Spark 并行计算模型 http://www.linuxidc.com/Linux/2012-12/76490.htm

0. 准备

出于学习目的,本文将 Spark 部署在虚拟机中,虚拟机选择 VMware WorkStation。在虚拟机中,需要安装以下软件:

- Ubuntu 14.04.1 LTS 64 位桌面版

- hadoop-2.4.0.tar.gz

- jdk-7u67-linux-x64.tar.gz

- scala-2.10.4.tgz

- spark-1.1.0-bin-hadoop2.4.tgz

Spark 的开发环境,本文选择 Windows7 平台,IDE 选择 IntelliJ IDEA。在 Windows 中,需要安装以下软件:

- IntelliJ IDEA 13.1.4 Community Edition

- apache-maven-3.2.3-bin.zip(安装过程比较简单,请读者自行安装)

1. 安装 JDK

解压 jdk 安装包到 /usr/lib 目录:

1 sudo cp jdk-7u67-linux-x64.gz /usr/lib

2 cd /usr/lib

3 sudo tar -xvzf jdk-7u67-linux-x64.gz

4 sudo gedit /etc/profile在 /etc/profile 文件的末尾添加环境变量:

1 export JAVA_HOME=/usr/lib/jdk1.7.0_67

2 export JRE_HOME=/usr/lib/jdk1.7.0_67/jre

3 export PATH=$JAVA_HOME/bin:$JRE_HOME/bin:$PATH

4 export CLASSPATH=.:$JAVA_HOME/lib:$JRE_HOME/lib:$CLASSPATH保存并更新 /etc/profile:

1 source /etc/profile测试 jdk 是否安装成功:

1 java -version

2. 安装及配置 SSH

1 sudo apt-get update

2 sudo apt-get install openssh-server

3 sudo /etc/init.d/ssh start生成并添加密钥:

1 ssh-keygen -t rsa -P ""

2 cd /home/hduser/.ssh

3 cat id_rsa.pub >> authorized_keysssh 登录:

1 ssh localhost

3. 安装 hadoop2.4.0

采用伪分布模式安装 hadoop2.4.0。解压 hadoop2.4.0 到 /usr/local 目录:

1 sudo cp hadoop-2.4.0.tar.gz /usr/local/

2 sudo tar -xzvf hadoop-2.4.0.tar.gz在 /etc/profile 文件的末尾添加环境变量:

1 export HADOOP_HOME=/usr/local/hadoop-2.4.0

2 export PATH=$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$PATH

3

4 export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native

5 export HADOOP_OPTS="-Djava.library.path=$HADOOP_HOME/lib"保存并更新 /etc/profile:

1 source /etc/profile在位于 /usr/local/hadoop-2.4.0/etc/hadoop 的 hadoop-env.sh 和 yarn-env.sh 文件中修改 jdk 路径:

1 cd /usr/local/hadoop-2.4.0/etc/hadoop

2 sudo gedit hadoop-env.sh

3 sudo gedit yarn-evn.shhadoop-env.sh:

yarn-env.sh:

修改 core-site.xml:

1 sudo gedit core-site.xml在 <configuration></configuration> 之间添加:

1 <property>

2 <name>fs.default.name</name>

3 <value>hdfs://localhost:9000</value>

4 </property>

5

6 <property>

7 <name>hadoop.tmp.dir</name>

8 <value>/app/hadoop/tmp</value>

9 </property>修改 hdfs-site.xml:

1 sudo gedit hdfs-site.xml在 <configuration></configuration> 之间添加:

修改 yarn-site.xml:

1 sudo gedit yarn-site.xml在 <configuration></configuration> 之间添加:

1 <property>

2 <name>mapreduce.framework.name</name>

3 <value>yarn</value>

4 </property>

5

6 <property>

7 <name>yarn.nodemanager.aux-services</name>

8 <value>mapreduce_shuffle</value>

9 </property>复制并重命名 mapred-site.xml.template 为 mapred-site.xml:

1 sudo cp mapred-site.xml.template mapred-site.xml

2 sudo gedit mapred-site.xml在 <configuration></configuration> 之间添加:

1 <property>

2 <name>mapreduce.jobtracker.address </name>

3 <value>hdfs://localhost:9001</value>

4 </property>在启动 hadoop 之前,为防止可能出现无法写入 log 的问题,记得为 /app 目录设置权限:

1 sudo mkdir /app

2 sudo chmod -R hduser:hduser /app格式化 hadoop:

1 hadoop namenode -format启动 hdfs 和 yarn。在开发 Spark 时,仅需要启动 hdfs:

1 sbin/start-dfs.sh

2 sbin/start-yarn.sh在浏览器中打开地址 http://localhost:50070/ 可以查看 hdfs 状态信息:

4. 安装 scala

1 sudo cp /home/hduser/Download/scala-2.9.3.tgz /usr/local

2 sudo tar -xvzf scala-2.9.3.tgz在 /etc/profile 文件的末尾添加环境变量:

1 export SCALA_HOME=/usr/local/scala-2.9.3

2 export PATH=$SCALA_HOME/bin:$PATH保存并更新 /etc/profile:

1 source /etc/profile测试 scala 是否安装成功:

1 scala -version

5. 安装 Spark

1 sudo cp spark-1.1.0-bin-hadoop2.4.tgz /usr/local

2 sudo tar -xvzf spark-1.1.0-bin-hadoop2.4.tgz在 /etc/profile 文件的末尾添加环境变量:

1 export SPARK_HOME=/usr/local/spark-1.1.0-bin-hadoop2.4

2 export PATH=$SPARK_HOME/bin:$PATH保存并更新 /etc/profile:

1 source /etc/profile复制并重命名 spark-env.sh.template 为 spark-env.sh:

1 sudo cp spark-env.sh.template spark-env.sh

2 sudo gedit spark-env.sh在 spark-env.sh 中添加:

1 export SCALA_HOME=/usr/local/scala-2.9.3

2 export JAVA_HOME=/usr/lib/jdk1.7.0_67

3 export SPARK_MASTER_IP=localhost

4 export SPARK_WORKER_MEMORY=1000m启动 Spark:

1 cd /usr/local/spark-1.1.0-bin-hadoop2.4

2 sbin/start-all.sh测试 Spark 是否安装成功:

1 cd /usr/local/spark-1.1.0-bin-hadoop2.4

2 bin/run-example SparkPi

6. 搭建 Spark 开发环境

本文开发 Spark 的 IDE 推荐 IntelliJ IDEA,当然也可以选择 Eclipse。在使用 IntelliJ IDEA 之前,需要安装 scala 的插件。点击 Configure:

点击 Plugins:

点击 Browse repositories…:

在搜索框内输入 scala,选择 Scala 插件进行安装。由于已经安装了这个插件,下图没有显示安装选项:

安装完成后,IntelliJ IDEA 会要求重启。

更多详情见请继续阅读下一页的精彩内容:http://www.linuxidc.com/Linux/2016-01/127856p2.htm