共计 12202 个字符,预计需要花费 31 分钟才能阅读完成。

环境

- 系统:Ubuntu 14.04 64bit

- Hadoop 版本:Hadoop 2.4.1 (stable)

- JDK 版本:OpenJDK 7

本教程基于 Hadoop 2.4.1,但对于 Hadoop 2.x 版本应该都是适用的。

创建 hadoop 用户

如果你安装 Ubuntu 的时候不是用的 hadoop 用户,那么需要增加一个名为 hadoop 的用户,并将密码设置为hadoop。

创建用户

sudo useradd hadoop

修改密码为hadoop,按提示输入两次密码

sudo passwd hadoop

给 hadoop 用户创建目录,方可登陆

sudo mkdir /home/hadoop

sudo chown hadoop /home/hadoop

可考虑为 hadoop 用户增加管理员权限,方便部署,避免一些权限不足的问题:

sudo adduser hadoop sudo

最后注销当前用户,使用 hadoop 用户进行登陆。

安装 SSH server、配置 SSH 无密码登陆

Ubuntu 默认安装了 SSH client,还需要安装 SSH server。

sudo apt-get install openssh-server

集群、单节点模式都需要用到 SSH 无密码登陆,首先设置 SSH 无密码登陆本机。

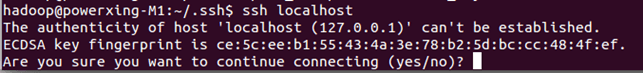

输入命令

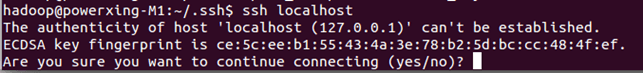

ssh localhost

会有如下提示(SSH 首次登陆提示),输入 yes。

SSH 首次登陆提示

SSH 首次登陆提示

然后按提示输入密码hadoop,这样就登陆到本机了。但这样的登陆是需要密码的,需要配置成无密码登陆。

先退出刚才的 ssh,然后生成 ssh 证书:

exit # 退出 ssh localhost

cd ~/.ssh # 如果没有该目录,先执行一次 ssh localhost

ssh-keygen -t rsa # 一直按回车就可以

cp id_rsa.pub authorized_keys

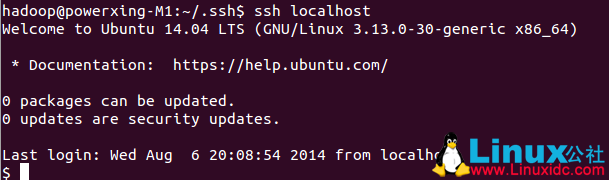

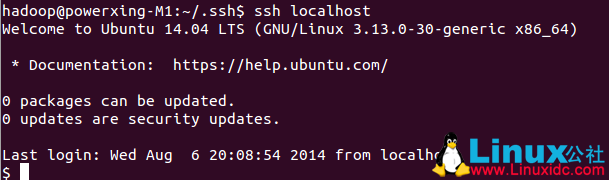

此时再用 ssh localhost 命令,就可以直接登陆了,如下图所示。

SSH 无密码登陆

安装 Java 环境

以前的教程都是建议安装 Oracle 的 JDK,不建议使用 OpenJDK,不过按 http://wiki.apache.org/hadoop/HadoopJavaVersions 中说的,新版本在 OpenJDK 1.7 下是没问题的。通过命令安装 OpenJDK 7。

sudo apt-get install openjdk-7-jre openjdk-7-jdk

默认的安装位置为: /usr/lib/jvm/java-7-openjdk-amd64 (可以通过命令 dpkg -L openjdk-7-jdk 看到)。安装完后就可以使用了,可以用 java -version 检查一下。

需要配置一下 JAVA_HOME 环境变量,这个环境变量很多地方都会用到,在 /etc/environment 中配置:

sudo vim /etc/environment

在文件末尾添加一行:

JAVA_HOME="/usr/lib/jvm/java-7-openjdk-amd64"

保存,最后需要注销然后再次登陆,或重启一下,才能保证 JAVA_HOME 在新打开的终端窗口中都能使用(注销、重启后,新打开一个终端窗口,输入 echo $JAVA_HOME 检验)。

安装 Hadoop 2.4.1

2.4.1 的下载地址为: http://mirrors.cnnic.cn/apache/hadoop/common/hadoop-2.4.1/hadoop-2.4.1.tar.gz,安装教程主要参考了官方教程 http://hadoop.apache.org/docs/stable/hadoop-project-dist/hadoop-common/SingleCluster.html。

CentOS 安装和配置 Hadoop2.2.0 http://www.linuxidc.com/Linux/2014-01/94685.htm

Ubuntu 13.04 上搭建 Hadoop 环境 http://www.linuxidc.com/Linux/2013-06/86106.htm

Ubuntu 12.10 +Hadoop 1.2.1 版本集群配置 http://www.linuxidc.com/Linux/2013-09/90600.htm

Ubuntu 上搭建 Hadoop 环境(单机模式 + 伪分布模式)http://www.linuxidc.com/Linux/2013-01/77681.htm

Ubuntu 下 Hadoop 环境的配置 http://www.linuxidc.com/Linux/2012-11/74539.htm

单机版搭建 Hadoop 环境图文教程详解 http://www.linuxidc.com/Linux/2012-02/53927.htm

搭建 Hadoop 环境(在 Winodws 环境下用虚拟机虚拟两个 Ubuntu 系统进行搭建)http://www.linuxidc.com/Linux/2011-12/48894.htm

下载后, 解压到 /usr/local/ 中。

sudo tar -zxvf ~/ 下载 /hadoop-2.4.1.tar.gz -C /usr/local # 解压到 /usr/local 中

sudo mv /usr/local/hadoop-2.4.1/ /usr/local/hadoop # 将文件名改为 hadoop

sudo chown -R hadoop:hadoop /usr/local/hadoop # 修改文件权限

Hadoop 解压后即可使用。输入如下命令 Hadoop 检查是否可用,成功则会显示命令行的用法:

/usr/local/hadoop/bin/hadoop

Hadoop 单机配置

Hadoop 默认配置是以非分布式模式运行,即单 Java 进程,方便进行调试。可以执行附带的例子 WordCount 来感受下 Hadoop 的运行。例子将 Hadoop 的配置文件作为输入文件,统计符合正则表达式 dfs[a-z.]+ 的单词的出现次数。

cd /usr/local/hadoop

mkdir input

cp etc/hadoop/*.xml input

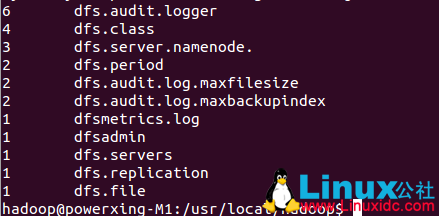

bin/hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.4.1.jar grep input output 'dfs[a-z.]+'

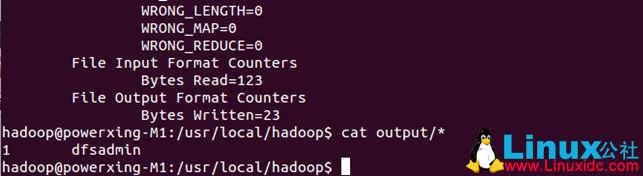

cat ./output/*

执行成功后如下所示,输出了作业的相关信息,输出的结果是符合正则的单词 dfsadmin 出现了 1 次

Hadoop 单机 WordCount 输出结果

Hadoop 单机 WordCount 输出结果

再次运行会提示出错,需要将 ./output 删除。

rm -R ./output

Hadoop 伪分布式配置

Hadoop 可以在单节点上以伪分布式的方式运行,Hadoop 进程以分离的 Java 进程来运行,节点即是 NameNode 也是 DataNode。需要修改 2 个配置文件 etc/hadoop/core-site.xml 和etc/hadoop/hdfs-site.xml。Hadoop 的配置文件是 xml 格式,声明 property 的 name 和 value。

修改配置文件etc/hadoop/core-site.xml,将

<configuration>

</configuration>

修改为下面配置:

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/usr/local/hadoop/tmp</value>

<description>Abase for other temporary directories.</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

修改配置文件 etc/hadoop/hdfs-site.xml 为

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/data</value>

</property>

</configuration>

关于配置的一点说明:上面只要配置 fs.defaultFS 和 dfs.replication 就可以运行,不过有个说法是如没有配置 hadoop.tmp.dir 参数,此时 Hadoop 默认的使用的临时目录为 /tmp/hadoo-hadoop,而这个目录在每次重启后都会被干掉,必须重新执行 format 才行(未验证),所以伪分布式配置中最好还是设置一下。此外也需要显式指定 dfs.namenode.name.dir 和 dfs.datanode.data.dir,否则下一步可能会出错。

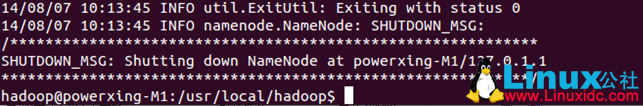

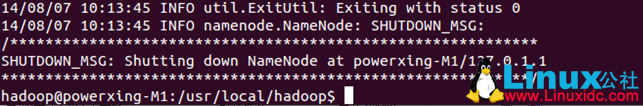

配置完成后,首先初始化文件系统 HDFS:

bin/hdfs namenode -format

成功的话,最后的提示如下,Exitting with status 0 表示成功,Exitting with status 1: 则是出错。若出错,可试着加上 sudo, 既 sudo bin/hdfs namenode -format 试试看。

初始化 HDFS 文件系统

初始化 HDFS 文件系统

接着开启 NaneNode 和DataNode守护进程。

sbin/start-dfs.sh

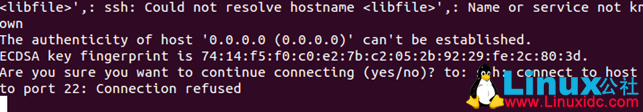

若出现下面 SSH 的提示,输入 yes 即可。

启动 Hadoop 时的 SSH 提示

启动 Hadoop 时的 SSH 提示

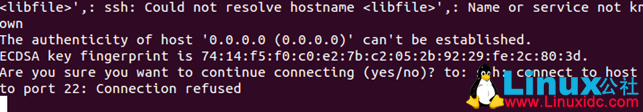

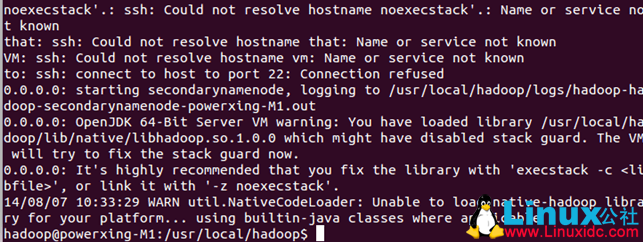

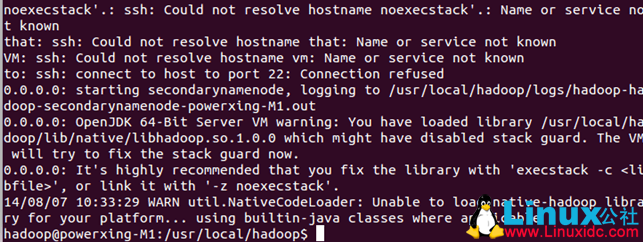

有可能会出现如下很多的 warn 提示,下面的步骤中也会出现,特别是 native-hadoop library 这个提示,可以忽略,并不会影响 hadoop 的功能。想解决这些提示可以看后面的附加教程(最好还是解决下,不困难,省得看这么多无用提示)。

启动 Hadoop 时的 warn 提示

启动 Hadoop 时的 warn 提示

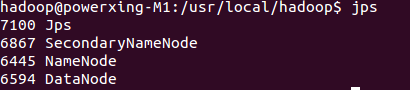

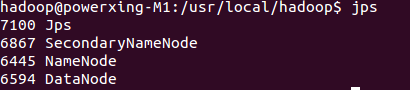

成功启动后,可以通过命令 jps 看到启动了如下进程 NameNode、DataNode 和SecondaryNameNode。

通过查看启动日志分析启动失败原因

有时 Hadoop 无法正确启动,如 NameNode 进程没有顺利启动,这时可以查看启动日志来排查原因,不过新手可能需要注意几点:

- 启动时会提示形如“Master: starting namenode, logging to /usr/local/hadoop/logs/hadoop-hadoop-namenode-Master.out”,其中 Master 对应你的机器名,但其实启动日志信息是记录在 /usr/local/hadoop/logs/hadoop-hadoop-namenode-Master.log 中,所以应该查看这个 .log 的文件;

- 每一次的启动日志都是追加在日志文件之后,所以得拉到最后面看,这个看下记录的时间就知道了。

- 一般出错的提示在最后面,也就是写着 Fatal、Error 或者 Java Exception 的地方。

通过 jps 查看启动的 Hadoop 进程

通过 jps 查看启动的 Hadoop 进程

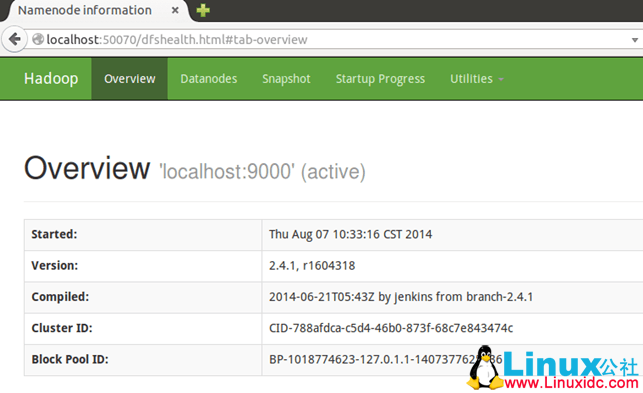

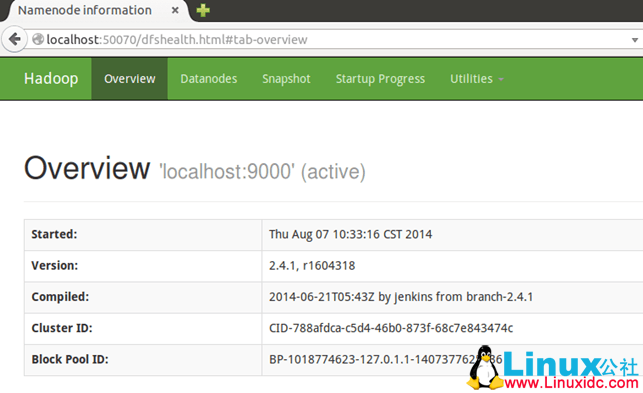

此时可以访问 Web 界面 http://localhost:50070 来查看 Hadoop 的信息。

Hadoop 的 Web 界面

更多详情见请继续阅读下一页的精彩内容:http://www.linuxidc.com/Linux/2015-02/113487p2.htm

Hadoop 伪分布式实例 -WordCount

首先创建所需的几个目录

bin/hdfs dfs -mkdir /user

bin/hdfs dfs -mkdir /user/hadoop

接着将 etc/hadoop 中的文件作为输入文件复制到分布式文件系统中,即将 /usr/local/hadoop/etc/hadoop 复制到分布式文件系统中的 /user/hadoop/input 中。上一步创建的 /user/hadoop 相当于 HDFS 中的用户当前目录,可以看到复制文件时无需指定绝对目录,下面的命令的目标路径就是 /user/hadoop/input:

bin/hdfs dfs -put etc/hadoop input

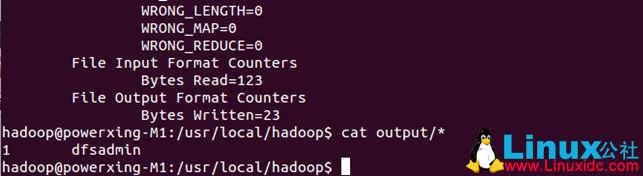

运行 MapReduce 作业,执行成功的话跟单机模式相同,输出作业信息。

bin/hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.4.1.jar grep input output 'dfs[a-z.]+'

查看运行结果

bin/hdfs dfs -cat output/*

也可以将运行结果取回到本地。

rm -R ./output

bin/hdfs dfs -get output output

cat ./output/*

结果如下,注意到跟单机模式中用的不是相同的数据,所以运行结果不同(换成原来的数据,结果是一致的)。

Hadoop 伪分布式运行 WordCout 结果

Hadoop 伪分布式运行 WordCout 结果

可以看到,使用 bin/hdfs dfs - 命令 可操作分布式文件系统,如

bin/hdfs dfs -ls /user/hadoop # 查看 `/user/hadoop` 中的文件

bin/hdfs dfs -rm -R /user/hadoop/input/* # 删除 input 中的文件

bin/hdfs dfs -rm -R /user/hadoop/output # 删除 output 文件夹

运行 Hadoop 程序时,结果的输出目录(如 output)不能存在,否则会提示错误,因此运行前需要先删除输出目录。建议在程序中加上如下代码进行删除,避免繁琐的命令行操作:

Configuration conf = new Configuration();

Job job = new Job(conf);

...

/* 删除输出目录 */

Path outputPath = new Path(args[1]);

outputPath.getFileSystem(conf).delete(outputPath, true);

...

结束 Hadoop 进程,则运行

sbin/stop-dfs.sh

下次再启动 hadoop,无需进行 HDFS 的初始化,只需要运行 sbin/stop-dfs.sh 就可以!

安装 Hadoop 集群

请查看教程 Hadoop 集群安装配置教程 http://www.linuxidc.com/Linux/2015-02/113486.htm

附加教程

解决 sbin/start-dfs.sh 中的 warn 提示

提示ssh: Could not resolve hostname *: Name or service not known

首先输入命令 hostname 看下自己的机器名,如我这边是 powerxing-M1。修改/etc/hosts,将127.0.1.1 powerxing-M1 改成192.168.1.121 powerxing-M1,即本机地址。

提示WARN util.NativeCodeLoader: Unable to load native-hadoop library for your platform… using builtin-Java classes where applicable

这是因为 hadoop native library 是 32 位系统编译的,在 64 位系统上会有这个提示,需要下载 hadoop 的源码重新编译,可参考 http://stackoverflow.com/questions/19943766/hadoop-unable-to-load-native-hadoop-library-for-your-platform-error-on-centos

我已经在 Ubuntu 14.04 64bit 上编译过了,可下载我编译的进行覆盖。

下载地址:

—————————————— 分割线 ——————————————

免费下载地址在 http://linux.linuxidc.com/

用户名与密码都是www.linuxidc.com

具体下载目录在 /2015 年资料 / 2 月 /15 日 /Ubuntu14.04 下 Hadoop2.4.1 单机 & 伪分布式配置教程 /

下载方法见 http://www.linuxidc.com/Linux/2013-07/87684.htm

—————————————— 分割线 ——————————————

下载后执行如下命令,替换掉原来的 navtive library。

rm -R /usr/local/hadoop/lib

tar -zxvf ~/ 下载 /lib.tar.gz -C /usr/local/hadoop

编译 Hadoop 源码

若想自己编译源码,需安装 g++ 和 Protocol Buffers(若访问不了可点此下载 http://pan.baidu.com/s/1ntIAoVR):

sudo tar -zxvf ~/ 下载 /protobuf-2.5.0.tar.gz -C /usr/local

sudo apt-get install g++

cd /usr/local/protobuf-2.5.0

sudo ./configure

sudo make

sudo make check

sudo make install

protoc –-version

最后一行代码应输出 protoc 的版本信息,若不能运行,则执行:

sudo ldconfig

protoc –-version

若提示出错错误“protoc: error while loading shared libraries: libprotoc.so.8: cannot open shared object file: No such file or directory”。则执行:

export LD_LIBRARY_PATH=/usr/local/lib/

安装后切换到 Hadoop 源码目录下,执行:

cd ~/hadoop-2.4.1-src

mvn package -Pdist,native -DskipTests -Dtar

编译完成后,在 hadoop-2.4.1-src/hadoop-dist/target 可看到。

更多 Hadoop 相关信息见Hadoop 专题页面 http://www.linuxidc.com/topicnews.aspx?tid=13

环境

- 系统:Ubuntu 14.04 64bit

- Hadoop 版本:Hadoop 2.4.1 (stable)

- JDK 版本:OpenJDK 7

本教程基于 Hadoop 2.4.1,但对于 Hadoop 2.x 版本应该都是适用的。

创建 hadoop 用户

如果你安装 Ubuntu 的时候不是用的 hadoop 用户,那么需要增加一个名为 hadoop 的用户,并将密码设置为hadoop。

创建用户

sudo useradd hadoop

修改密码为hadoop,按提示输入两次密码

sudo passwd hadoop

给 hadoop 用户创建目录,方可登陆

sudo mkdir /home/hadoop

sudo chown hadoop /home/hadoop

可考虑为 hadoop 用户增加管理员权限,方便部署,避免一些权限不足的问题:

sudo adduser hadoop sudo

最后注销当前用户,使用 hadoop 用户进行登陆。

安装 SSH server、配置 SSH 无密码登陆

Ubuntu 默认安装了 SSH client,还需要安装 SSH server。

sudo apt-get install openssh-server

集群、单节点模式都需要用到 SSH 无密码登陆,首先设置 SSH 无密码登陆本机。

输入命令

ssh localhost

会有如下提示(SSH 首次登陆提示),输入 yes。

SSH 首次登陆提示

SSH 首次登陆提示

然后按提示输入密码hadoop,这样就登陆到本机了。但这样的登陆是需要密码的,需要配置成无密码登陆。

先退出刚才的 ssh,然后生成 ssh 证书:

exit # 退出 ssh localhost

cd ~/.ssh # 如果没有该目录,先执行一次 ssh localhost

ssh-keygen -t rsa # 一直按回车就可以

cp id_rsa.pub authorized_keys

此时再用 ssh localhost 命令,就可以直接登陆了,如下图所示。

SSH 无密码登陆

安装 Java 环境

以前的教程都是建议安装 Oracle 的 JDK,不建议使用 OpenJDK,不过按 http://wiki.apache.org/hadoop/HadoopJavaVersions 中说的,新版本在 OpenJDK 1.7 下是没问题的。通过命令安装 OpenJDK 7。

sudo apt-get install openjdk-7-jre openjdk-7-jdk

默认的安装位置为: /usr/lib/jvm/java-7-openjdk-amd64 (可以通过命令 dpkg -L openjdk-7-jdk 看到)。安装完后就可以使用了,可以用 java -version 检查一下。

需要配置一下 JAVA_HOME 环境变量,这个环境变量很多地方都会用到,在 /etc/environment 中配置:

sudo vim /etc/environment

在文件末尾添加一行:

JAVA_HOME="/usr/lib/jvm/java-7-openjdk-amd64"

保存,最后需要注销然后再次登陆,或重启一下,才能保证 JAVA_HOME 在新打开的终端窗口中都能使用(注销、重启后,新打开一个终端窗口,输入 echo $JAVA_HOME 检验)。

安装 Hadoop 2.4.1

2.4.1 的下载地址为: http://mirrors.cnnic.cn/apache/hadoop/common/hadoop-2.4.1/hadoop-2.4.1.tar.gz,安装教程主要参考了官方教程 http://hadoop.apache.org/docs/stable/hadoop-project-dist/hadoop-common/SingleCluster.html。

CentOS 安装和配置 Hadoop2.2.0 http://www.linuxidc.com/Linux/2014-01/94685.htm

Ubuntu 13.04 上搭建 Hadoop 环境 http://www.linuxidc.com/Linux/2013-06/86106.htm

Ubuntu 12.10 +Hadoop 1.2.1 版本集群配置 http://www.linuxidc.com/Linux/2013-09/90600.htm

Ubuntu 上搭建 Hadoop 环境(单机模式 + 伪分布模式)http://www.linuxidc.com/Linux/2013-01/77681.htm

Ubuntu 下 Hadoop 环境的配置 http://www.linuxidc.com/Linux/2012-11/74539.htm

单机版搭建 Hadoop 环境图文教程详解 http://www.linuxidc.com/Linux/2012-02/53927.htm

搭建 Hadoop 环境(在 Winodws 环境下用虚拟机虚拟两个 Ubuntu 系统进行搭建)http://www.linuxidc.com/Linux/2011-12/48894.htm

下载后, 解压到 /usr/local/ 中。

sudo tar -zxvf ~/ 下载 /hadoop-2.4.1.tar.gz -C /usr/local # 解压到 /usr/local 中

sudo mv /usr/local/hadoop-2.4.1/ /usr/local/hadoop # 将文件名改为 hadoop

sudo chown -R hadoop:hadoop /usr/local/hadoop # 修改文件权限

Hadoop 解压后即可使用。输入如下命令 Hadoop 检查是否可用,成功则会显示命令行的用法:

/usr/local/hadoop/bin/hadoop

Hadoop 单机配置

Hadoop 默认配置是以非分布式模式运行,即单 Java 进程,方便进行调试。可以执行附带的例子 WordCount 来感受下 Hadoop 的运行。例子将 Hadoop 的配置文件作为输入文件,统计符合正则表达式 dfs[a-z.]+ 的单词的出现次数。

cd /usr/local/hadoop

mkdir input

cp etc/hadoop/*.xml input

bin/hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.4.1.jar grep input output 'dfs[a-z.]+'

cat ./output/*

执行成功后如下所示,输出了作业的相关信息,输出的结果是符合正则的单词 dfsadmin 出现了 1 次

Hadoop 单机 WordCount 输出结果

Hadoop 单机 WordCount 输出结果

再次运行会提示出错,需要将 ./output 删除。

rm -R ./output

Hadoop 伪分布式配置

Hadoop 可以在单节点上以伪分布式的方式运行,Hadoop 进程以分离的 Java 进程来运行,节点即是 NameNode 也是 DataNode。需要修改 2 个配置文件 etc/hadoop/core-site.xml 和etc/hadoop/hdfs-site.xml。Hadoop 的配置文件是 xml 格式,声明 property 的 name 和 value。

修改配置文件etc/hadoop/core-site.xml,将

<configuration>

</configuration>

修改为下面配置:

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/usr/local/hadoop/tmp</value>

<description>Abase for other temporary directories.</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

修改配置文件 etc/hadoop/hdfs-site.xml 为

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/data</value>

</property>

</configuration>

关于配置的一点说明:上面只要配置 fs.defaultFS 和 dfs.replication 就可以运行,不过有个说法是如没有配置 hadoop.tmp.dir 参数,此时 Hadoop 默认的使用的临时目录为 /tmp/hadoo-hadoop,而这个目录在每次重启后都会被干掉,必须重新执行 format 才行(未验证),所以伪分布式配置中最好还是设置一下。此外也需要显式指定 dfs.namenode.name.dir 和 dfs.datanode.data.dir,否则下一步可能会出错。

配置完成后,首先初始化文件系统 HDFS:

bin/hdfs namenode -format

成功的话,最后的提示如下,Exitting with status 0 表示成功,Exitting with status 1: 则是出错。若出错,可试着加上 sudo, 既 sudo bin/hdfs namenode -format 试试看。

初始化 HDFS 文件系统

初始化 HDFS 文件系统

接着开启 NaneNode 和DataNode守护进程。

sbin/start-dfs.sh

若出现下面 SSH 的提示,输入 yes 即可。

启动 Hadoop 时的 SSH 提示

启动 Hadoop 时的 SSH 提示

有可能会出现如下很多的 warn 提示,下面的步骤中也会出现,特别是 native-hadoop library 这个提示,可以忽略,并不会影响 hadoop 的功能。想解决这些提示可以看后面的附加教程(最好还是解决下,不困难,省得看这么多无用提示)。

启动 Hadoop 时的 warn 提示

启动 Hadoop 时的 warn 提示

成功启动后,可以通过命令 jps 看到启动了如下进程 NameNode、DataNode 和SecondaryNameNode。

通过查看启动日志分析启动失败原因

有时 Hadoop 无法正确启动,如 NameNode 进程没有顺利启动,这时可以查看启动日志来排查原因,不过新手可能需要注意几点:

- 启动时会提示形如“Master: starting namenode, logging to /usr/local/hadoop/logs/hadoop-hadoop-namenode-Master.out”,其中 Master 对应你的机器名,但其实启动日志信息是记录在 /usr/local/hadoop/logs/hadoop-hadoop-namenode-Master.log 中,所以应该查看这个 .log 的文件;

- 每一次的启动日志都是追加在日志文件之后,所以得拉到最后面看,这个看下记录的时间就知道了。

- 一般出错的提示在最后面,也就是写着 Fatal、Error 或者 Java Exception 的地方。

通过 jps 查看启动的 Hadoop 进程

通过 jps 查看启动的 Hadoop 进程

此时可以访问 Web 界面 http://localhost:50070 来查看 Hadoop 的信息。

Hadoop 的 Web 界面

更多详情见请继续阅读下一页的精彩内容:http://www.linuxidc.com/Linux/2015-02/113487p2.htm