共计 2104 个字符,预计需要花费 6 分钟才能阅读完成。

集群共三台 CentOS 虚拟机,一个 Matser,主机名为 master;三个 Worker,主机名分别为 master、slave03、slave04。前提是 Hadoop 和 Zookeeper 已经安装并且开始运行。

1. 在 master 上下载 Scala-2.11.0.tgz,复制到 /opt/ 下面,解压,在 /etc/profile 加上语句:

export SCALA_HOME=/opt/scala-2.11.0

export PATH=$PATH:$SCALA_HOME/bin然后运行命令:

source /etc/profile在 slave03、slave04 上也执行相同的操作。

2. 在 master 上下载 spark-2.1.0-bin-hadoop2.6,复制到 /opt/ 下面。解压,在 /etc/profile 加上语句:

export SPARK_HOME=/opt/spark-2.1.0-bin-hadoop2.6

export PATH=$PATH:$SPARK_HOME/bin:$SPARK_HOME/sbin然后运行命令:

source /etc/profile3. 编辑 ${SPARK_HOME}/conf/spark-env.sh 文件,增加下面的语句:

# Java_HOME

export JAVA_HOME=/opt/jdk1.8.0_121

# SCALA_HOME

export SCALA_HOME=/opt/scala-2.11.0

# SPARK_HOME

export SPARK_HOME=/opt/spark-2.1.0-bin-hadoop2.6

# Master 主机名

export SPARK_MASTER_HOST=master

# Worker 的内存大小

export SPARK_WORKER_MEMORY=1g

# Worker 的 Cores 数量

export SPARK_WORKER_CORES=1

# SPARK_PID 路径

export SPARK_PID_DIR=$SPARK_HOME/tmp

# Hadoop 配置文件路径

export HADOOP_CONF_DIR=/opt/hadoop-2.6.0-cdh5.9.0/etc/hadoop

# Spark 的 Recovery Mode、Zookeeper URL 和路径

export SPARK_DAEMON_JAVA_OPTS="-Dspark.deploy.recoveryMode=ZOOKEEPER -Dspark.deploy.zookeeper.url=master:12181,slave03:12181,slave04:12181 -Dspark.deploy.zookeeper.dir=/spark"在 ${SPARK_HOME}/conf/slaves 中增加:

matser

slave03

slave04这样就设置了三个 Worker。

修改文件结束以后,将 ${SPARK_HOME}用 scp 复制到 slave03 和 slave04。

4. 在 master 上进入 ${SPARK_HOME}/sbin 路径,运行:

./start-master.sh这是启动 Master。

再运行:

./start-slaves.sh这是启动 Worker。

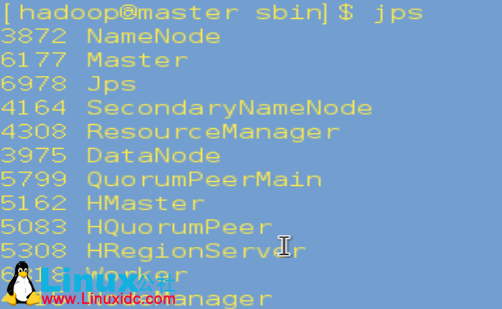

5. 在 master 上运行 jps,如果有 Master 和 Worker 表明启动成功:

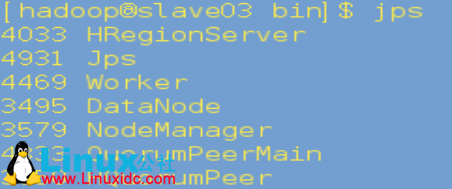

在 slave03、slave04 上运行 jps,有 Worker 表明启动成功:

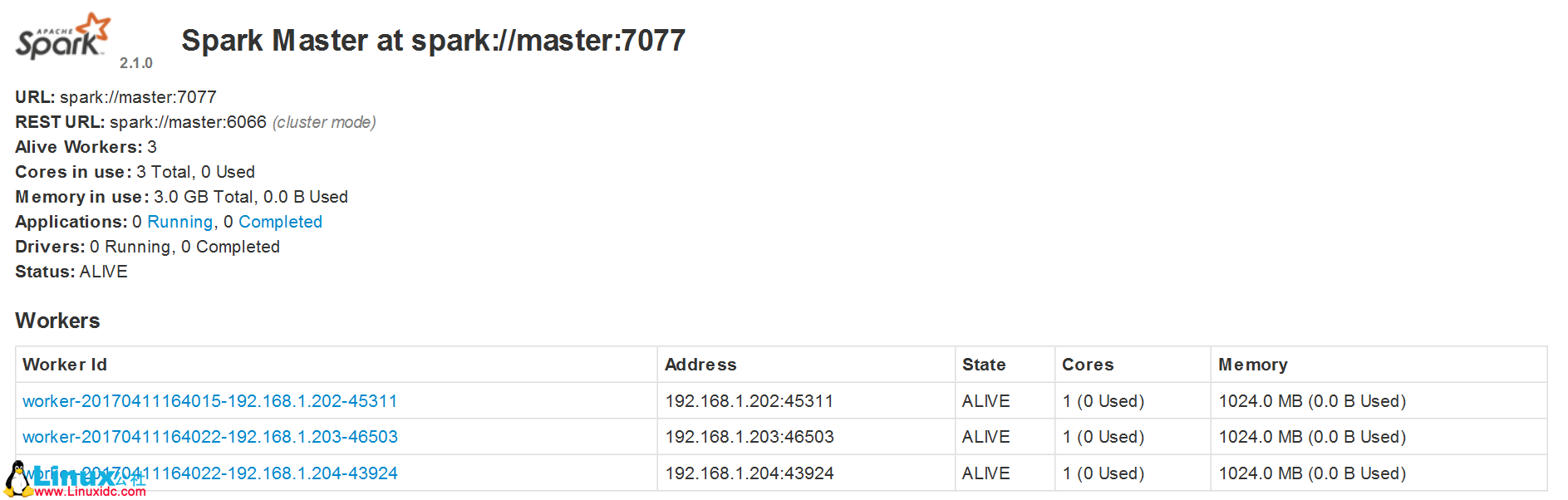

6. 访问 http://master:8081,出现下面的页面表明启动成功:

更多 Spark 相关教程见以下内容:

CentOS 7.0 下安装并配置 Spark http://www.linuxidc.com/Linux/2015-08/122284.htm

Spark1.0.0 部署指南 http://www.linuxidc.com/Linux/2014-07/104304.htm

Spark2.0 安装配置文档 http://www.linuxidc.com/Linux/2016-09/135352.htm

Spark 1.5、Hadoop 2.7 集群环境搭建 http://www.linuxidc.com/Linux/2016-09/135067.htm

Spark 官方文档 – 中文翻译 http://www.linuxidc.com/Linux/2016-04/130621.htm

CentOS 6.2(64 位)下安装 Spark0.8.0 详细记录 http://www.linuxidc.com/Linux/2014-06/102583.htm

Spark2.0.2 Hadoop2.6.4 全分布式配置详解 http://www.linuxidc.com/Linux/2016-11/137367.htm

Ubuntu 14.04 LTS 安装 Spark 1.6.0(伪分布式)http://www.linuxidc.com/Linux/2016-03/129068.htm

Spark 的详细介绍:请点这里

Spark 的下载地址:请点这里

本文永久更新链接地址:http://www.linuxidc.com/Linux/2017-04/142695.htm