共计 10030 个字符,预计需要花费 26 分钟才能阅读完成。

一、概述

随着公司集群升级到 2.x,Hadoop 周边的一些工具也进行了版本的更新。这次主要说说 sqoop2 的升级和部署,其中 sqoop1 和 sqoop2 基本框架和用法发生翻天覆地的改变,其对版本的向下兼容做的十分不好,接下来慢慢说,总之各种值得吐槽的地方。

二、sqoop2 的基本框架,以及部署

(1) 首先说说 sqoop1 和 sqoop2 区别

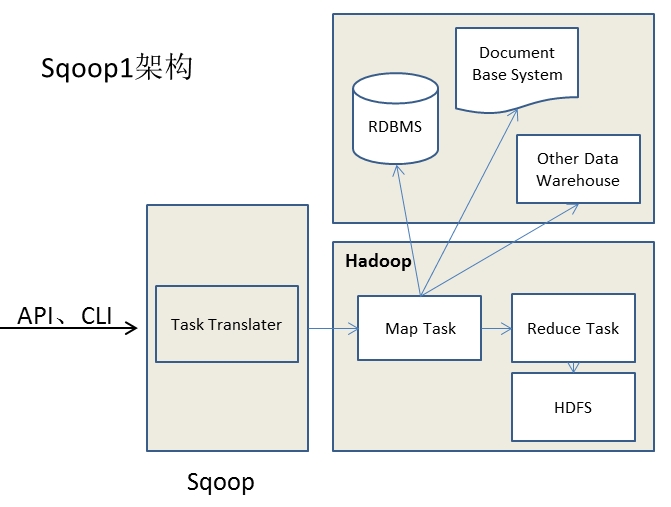

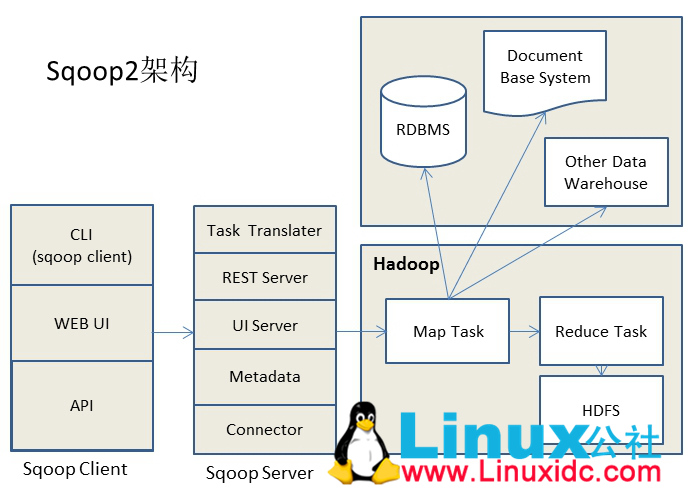

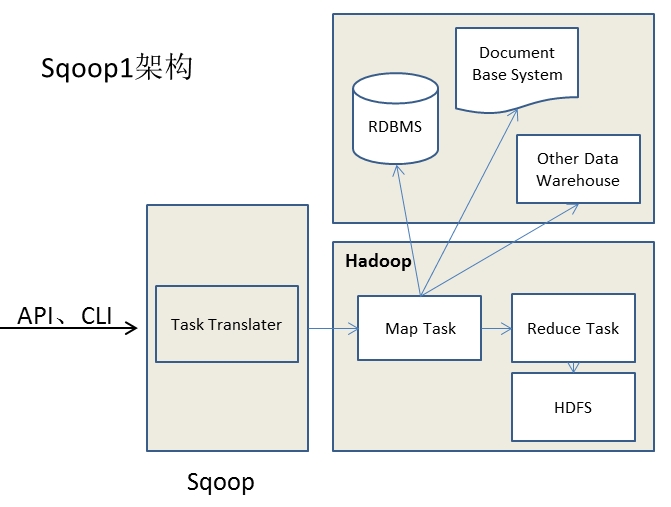

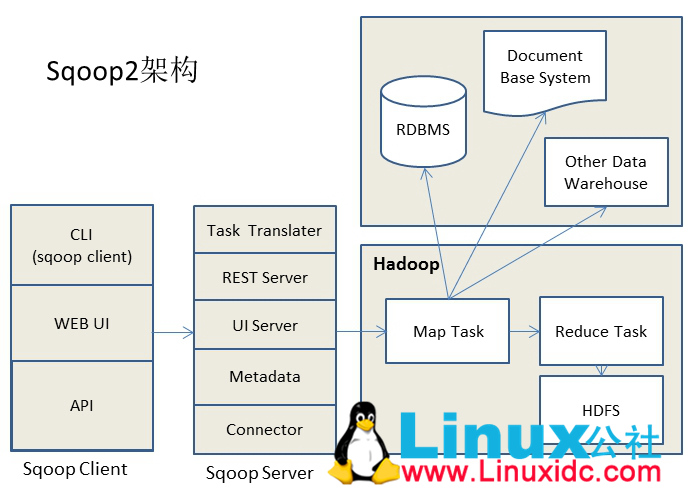

这两个版本是完全不兼容的,其具体的版本号区别为 1.4.x 为 sqoop1,1.99x 为 sqoop2。sqoop1 和 sqoop2 在架构和用法上已经完全不同。

在架构上,sqoop2 引入了 sqoop server(具体服务器为 tomcat),对 connector 实现了集中的管理。其访问方式也变得多样化了,其可以通过 REST API、JAVA API、WEB UI 以及 CLI 控制台方式进行访问。另外,其在安全性能方面也有一定的改善,在 sqoop1 中我们经常用脚本的方式将 HDFS 中的数据导入到 mysql 中,或者反过来将 mysql 数据导入到 HDFS 中,其中在脚本里边都要显示指定 mysql 数据库的用户名和密码的,安全性做的不是太完善。在 sqoop2 中,如果是通过 CLI 方式访问的话,会有一个交互过程界面,你输入的密码信息不被看到。下图是 sqoop1 和 sqoop2 简单架构对比:

通过 Sqoop 实现 Mysql / Oracle 与 HDFS / Hbase 互导数据 http://www.linuxidc.com/Linux/2013-06/85817.htm

[Hadoop] Sqoop 安装过程详解 http://www.linuxidc.com/Linux/2013-05/84082.htm

用 Sqoop 进行 MySQL 和 HDFS 系统间的数据互导 http://www.linuxidc.com/Linux/2013-04/83447.htm

Hadoop Oozie 学习笔记 Oozie 不支持 Sqoop 问题解决 http://www.linuxidc.com/Linux/2012-08/67027.htm

Hadoop 生态系统搭建(hadoop hive hbase zookeeper oozie Sqoop)http://www.linuxidc.com/Linux/2012-03/55721.htm

Hadoop 学习全程记录——使用 Sqoop 将 MySQL 中数据导入到 Hive 中 http://www.linuxidc.com/Linux/2012-01/51993.htm

(2)sqoop2 部署步骤

1、下载 sqoop-1.99.x 版本的 sqoop,并进行解压。

2、配置好 SQOOP_HOME 等环境变量,并用 source 是~/.bash_profile 文件即时生效。

3、配置 sqoop server

修改 $SQOOP_HOME/server/conf/catalina.properties,修改 common.loader 属性,加入 hadoop2.x 的各种 lib 包,具体指向路径为 $HADOOP_HOME/share/hadoop/common/*.jar,

$HADOOP_HOME/share/hadoop/common/lib/*.jar,$HADOOP_HOME/share/hadoop/yarn/*.jar,$HADOOP_HOME/share/hadoop/hdfs/*.jar,$HADOOP_HOME,/share/hadoop/mapreduce/*.jar,没有路径用逗号分开。另外,在 $SQOOP_HOME 中建个文件夹例如 hadoop_lib,然后将这些 jar 包 cp 到此文件夹中,最后将此文件夹路径添加到 common.loader 属性中,这种方法更加直观些。

修改 $SQOOP_HOME/server/conf/sqoop.properties,修改 org.apache.sqoop.submission.engine.mapreduce.configuration.directory 属性值为 $HADOOP_HOME/etc/hadoop。

另外,要主要一下 $SQOOP_HOME/server/conf/server.xml 中的 tomcat 端口问题,确保这些端口不会和你其他 tomcat 服务器冲突。

修改配置完毕就可以启动 sqoop server 了,启动命令:$SQOOP_HOME/bin/sqoop.sh server start,启动完看服务器日志如果没有错误就 ok 了。

在修改 sqoop server 配置文件,启动过程中你可能会遇到各种问题,这些问题可能是 log4j 或者是 tomcat 的相关错误问题,还是不难解决的。其中包冲突问题我就遇到了,看 sqoop server 日志:

刚刚看到这个错误信息可能不容易往 jar 包冲突这方面想,出现这个错误的原因是刚刚 $SQOOP_HOME/server/conf/catalina.properties 文件 common.loader 属性中的 hadoop2.x lib 中的 jar 包和 sqoop server 的 web 项目中的 lib 中的包冲突了,解决方法可以将 $SQOOP_HOME/server/webapps/sqoop/WEB-INF/lib 中的 log4j-1.2.16.jar 删掉就 ok 了。

更多详情见请继续阅读下一页的精彩内容 :http://www.linuxidc.com/Linux/2014-10/107935p2.htm

三、sqoop2 的 Java API 使用

sqoop2 中的 java api 使用方式和 sqoop1 是完全不同的。其基本流程为:

1、添加 sqoop2 的 Dependency 包。

<dependency>

<groupId>org.apache.sqoop</groupId>

<artifactId>sqoop-client</artifactId><br> <version>1.99.3</version>

</dependency>

2、创建 Connetion。

3、利用之前创建的 ConnectionID 去创建 job。

4、提交 job。

具体代码整理了一下:

import org.apache.sqoop.client.SqoopClient;

import org.apache.sqoop.model.MConnection;

import org.apache.sqoop.model.MConnectionForms;

import org.apache.sqoop.model.MJob;

import org.apache.sqoop.model.MJobForms;

import org.apache.sqoop.model.MSubmission;

import org.apache.sqoop.submission.counter.Counter;

import org.apache.sqoop.submission.counter.CounterGroup;

import org.apache.sqoop.submission.counter.Counters;

import org.apache.sqoop.validation.Status;

public class Sqoop2Access {

public static void main(String[] args) {

//1、————–Initialization(创建 sqoop client)——————-

String url = “http://localhost:12000/sqoop/”;

SqoopClient client = new SqoopClient(url);

client.setServerUrl(url);

//2、————–Create Connection————–

//Dummy connection object

MConnection newCon = client.newConnection(1);// 1 为指定的 ConnectionID

//Get connection and framework forms. Set name for connection

MConnectionForms conForms = newCon.getConnectorPart();

MConnectionForms frameworkForms = newCon.getFrameworkPart();

newCon.setName(“MyConnection”);

//Set connection forms values

conForms.getStringInput(“connection.connectionString”).setValue(“jdbc:mysql://localhost/mysqlTestDB”);

conForms.getStringInput(“connection.jdbcDriver”).setValue(“com.mysql.jdbc.Driver”);

conForms.getStringInput(“connection.username”).setValue(“root”);

conForms.getStringInput(“connection.password”).setValue(“root”);

frameworkForms.getIntegerInput(“security.maxConnections”).setValue(0);

Status status = client.createConnection(newCon);

// 检测链接的相关状态

if(status.canProceed()) {

System.out.println(“Created. New Connection ID : ” +newCon.getPersistenceId());

} else {

System.out.println(“Check for status and forms error “);

}

//3、————–create job(import job)————–

//Creating dummy job object(利用 connectionID 去创建 job)

MJob newjob = client.newJob(newCon.getPersistenceId(), org.apache.sqoop.model.MJob.Type.IMPORT);

MJobForms connectorForm = newjob.getConnectorPart();

MJobForms frameworkForm = newjob.getFrameworkPart();

newjob.setName(“ImportJob”);

//Database configuration

connectorForm.getStringInput(“table.schemaName”).setValue(“”);

//Input either table name or sql

connectorForm.getStringInput(“table.tableName”).setValue(“table”);

//connectorForm.getStringInput(“table.sql”).setValue(“select id,name from table where ${CONDITIONS}”);

connectorForm.getStringInput(“table.columns”).setValue(“id,name”);

connectorForm.getStringInput(“table.partitionColumn”).setValue(“id”);

//Set boundary value only if required

//connectorForm.getStringInput(“table.boundaryQuery”).setValue(“”);

//Output configurations

frameworkForm.getEnumInput(“output.storageType”).setValue(“HDFS”);

frameworkForm.getEnumInput(“output.outputFormat”).setValue(“TEXT_FILE”);//Other option: SEQUENCE_FILE

frameworkForm.getStringInput(“output.outputDirectory”).setValue(“/output”);

//Job resources

frameworkForm.getIntegerInput(“throttling.extractors”).setValue(1);

frameworkForm.getIntegerInput(“throttling.loaders”).setValue(1);

Status statusJob = client.createJob(newjob);

// 检测作业状态相关信息

if(statusJob.canProceed()) {

System.out.println(“New Job ID: “+ newjob.getPersistenceId());

} else {

System.out.println(“Check for status and forms error “);

}

//4、————–Job Submission————–

//Job submission start

MSubmission submission = client.startSubmission(newjob.getPersistenceId());

System.out.println(“Status : ” + submission.getStatus());

if(submission.getStatus().isRunning() && submission.getProgress() != -1) {

System.out.println(“Progress : ” + String.format(“%.2f %%”, submission.getProgress() * 100));

}

System.out.println(“Hadoop job id :” + submission.getExternalId());

System.out.println(“Job link : ” + submission.getExternalLink());

Counters counters = submission.getCounters();

if(counters != null) {

System.out.println(“Counters:”);

for(CounterGroup group : counters) {

System.out.print(“\t”);

System.out.println(group.getName());

for(Counter counter : group) {

System.out.print(“\t\t”);

System.out.print(counter.getName());

System.out.print(“: “);

System.out.println(counter.getValue());

}

}

}

if(submission.getExceptionInfo() != null) {

System.out.println(“Exception info : ” +submission.getExceptionInfo());

}

//Check job status

MSubmission submission1 = client.getSubmissionStatus(newjob.getPersistenceId());

if(submission1.getStatus().isRunning() && submission1.getProgress() != -1) {

System.out.println(“Progress : ” + String.format(“%.2f %%”, submission1.getProgress() * 100));

}

//Stop a running job

//submission1.stopSubmission(jid);

}

}

另外,如果你使用 CLI 直接访问的话请参考:http://sqoop.apache.org/docs/1.99.3/CommandLineClient.html;REST API 方式访问请参考:http://sqoop.apache.org/docs/1.99.3/RESTAPI.html。

四、sqoop2 的安装和使用总结

在 sqoop2 的升级部署以及使用的过程中有诸多吐槽的地方。第一,sqoop2 的部署相比于 sqoop1 复杂的多,虽然官方网站中的 install guide 中的文档还是比较详细的,但是其中没有考虑到 hadoop 和 sqoop webSite 包冲突问题,以及没有对在部署过程中有可能出现的问题进行相关提示。第二,sqoop2 和 sqoop1 的兼容性问题没有做到很好的处理,这个是我个人最不能忍受的地方。其中,体现的最明显的地方就是,之前我在公司写项目的时候是用 sqoop1 的 import 或者 export 脚本去实现 HDFS 和 RDBMS 之间的数据转移的,现在我将 sqoop1 升级到 sqoop2 之后,import 和 export 脚本再也无法使用了,这样的话我不得不重新将在项目中用 sqoop1 中的 import 和 export 脚本实现的功能用 JAVA API 去重新编写,这样使得升级超级不平滑,我认为这个是 sqoop2 做的最不好的地方。

参考文献:http://sqoop.apache.org/docs/1.99.3/index.html

Sqoop 的详细介绍 :请点这里

Sqoop 的下载地址 :请点这里

一、概述

随着公司集群升级到 2.x,Hadoop 周边的一些工具也进行了版本的更新。这次主要说说 sqoop2 的升级和部署,其中 sqoop1 和 sqoop2 基本框架和用法发生翻天覆地的改变,其对版本的向下兼容做的十分不好,接下来慢慢说,总之各种值得吐槽的地方。

二、sqoop2 的基本框架,以及部署

(1) 首先说说 sqoop1 和 sqoop2 区别

这两个版本是完全不兼容的,其具体的版本号区别为 1.4.x 为 sqoop1,1.99x 为 sqoop2。sqoop1 和 sqoop2 在架构和用法上已经完全不同。

在架构上,sqoop2 引入了 sqoop server(具体服务器为 tomcat),对 connector 实现了集中的管理。其访问方式也变得多样化了,其可以通过 REST API、JAVA API、WEB UI 以及 CLI 控制台方式进行访问。另外,其在安全性能方面也有一定的改善,在 sqoop1 中我们经常用脚本的方式将 HDFS 中的数据导入到 mysql 中,或者反过来将 mysql 数据导入到 HDFS 中,其中在脚本里边都要显示指定 mysql 数据库的用户名和密码的,安全性做的不是太完善。在 sqoop2 中,如果是通过 CLI 方式访问的话,会有一个交互过程界面,你输入的密码信息不被看到。下图是 sqoop1 和 sqoop2 简单架构对比:

通过 Sqoop 实现 Mysql / Oracle 与 HDFS / Hbase 互导数据 http://www.linuxidc.com/Linux/2013-06/85817.htm

[Hadoop] Sqoop 安装过程详解 http://www.linuxidc.com/Linux/2013-05/84082.htm

用 Sqoop 进行 MySQL 和 HDFS 系统间的数据互导 http://www.linuxidc.com/Linux/2013-04/83447.htm

Hadoop Oozie 学习笔记 Oozie 不支持 Sqoop 问题解决 http://www.linuxidc.com/Linux/2012-08/67027.htm

Hadoop 生态系统搭建(hadoop hive hbase zookeeper oozie Sqoop)http://www.linuxidc.com/Linux/2012-03/55721.htm

Hadoop 学习全程记录——使用 Sqoop 将 MySQL 中数据导入到 Hive 中 http://www.linuxidc.com/Linux/2012-01/51993.htm

(2)sqoop2 部署步骤

1、下载 sqoop-1.99.x 版本的 sqoop,并进行解压。

2、配置好 SQOOP_HOME 等环境变量,并用 source 是~/.bash_profile 文件即时生效。

3、配置 sqoop server

修改 $SQOOP_HOME/server/conf/catalina.properties,修改 common.loader 属性,加入 hadoop2.x 的各种 lib 包,具体指向路径为 $HADOOP_HOME/share/hadoop/common/*.jar,

$HADOOP_HOME/share/hadoop/common/lib/*.jar,$HADOOP_HOME/share/hadoop/yarn/*.jar,$HADOOP_HOME/share/hadoop/hdfs/*.jar,$HADOOP_HOME,/share/hadoop/mapreduce/*.jar,没有路径用逗号分开。另外,在 $SQOOP_HOME 中建个文件夹例如 hadoop_lib,然后将这些 jar 包 cp 到此文件夹中,最后将此文件夹路径添加到 common.loader 属性中,这种方法更加直观些。

修改 $SQOOP_HOME/server/conf/sqoop.properties,修改 org.apache.sqoop.submission.engine.mapreduce.configuration.directory 属性值为 $HADOOP_HOME/etc/hadoop。

另外,要主要一下 $SQOOP_HOME/server/conf/server.xml 中的 tomcat 端口问题,确保这些端口不会和你其他 tomcat 服务器冲突。

修改配置完毕就可以启动 sqoop server 了,启动命令:$SQOOP_HOME/bin/sqoop.sh server start,启动完看服务器日志如果没有错误就 ok 了。

在修改 sqoop server 配置文件,启动过程中你可能会遇到各种问题,这些问题可能是 log4j 或者是 tomcat 的相关错误问题,还是不难解决的。其中包冲突问题我就遇到了,看 sqoop server 日志:

刚刚看到这个错误信息可能不容易往 jar 包冲突这方面想,出现这个错误的原因是刚刚 $SQOOP_HOME/server/conf/catalina.properties 文件 common.loader 属性中的 hadoop2.x lib 中的 jar 包和 sqoop server 的 web 项目中的 lib 中的包冲突了,解决方法可以将 $SQOOP_HOME/server/webapps/sqoop/WEB-INF/lib 中的 log4j-1.2.16.jar 删掉就 ok 了。

更多详情见请继续阅读下一页的精彩内容 :http://www.linuxidc.com/Linux/2014-10/107935p2.htm