共计 4643 个字符,预计需要花费 12 分钟才能阅读完成。

1 Flume 简介

Flume 是 Cloudera 提供的一个高可用、高可靠、分布式的海量日志采集、聚合和传输的系统。Flume 支持在日志系统中定制各类数据发送方用于收集数据,同时 Flume 提供对数据的简单处理,并将数据处理结果写入各种数据接收方的能力。

Flume 作为 Cloudera 开发的实时日志收集系统,受到了业界的认可与广泛应用。2010 年 11 月 Cloudera 开源了 Flume 的第一个可用版本 0.9.2,这个系列版本被统称为 Flume-OG。随着 Flume 功能的扩展,Flume-OG 代码工程臃肿、核心组件设计不合理、核心配置不标准等缺点暴露出来,尤其是在 Flume-OG 的最后一个发行版本 0.94.0 中,日志传输不稳定的现象尤为严重。为了解决这些问题,2011 年 10 月 Cloudera 重构了核心组件、核心配置和代码架构,重构后的版本统称为 Flume-NG。改动的另一原因是将 Flume 纳入 Apache 旗下,Cloudera Flume 改名为 Apache Flume。

2 Flume 工作原理

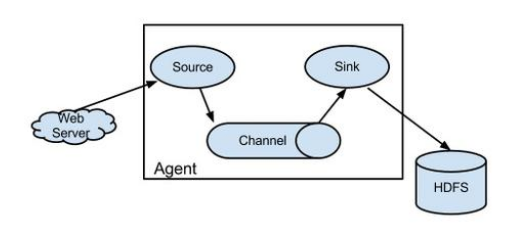

Flume 的数据流由事件(Event)贯穿始终。事件是 Flume 的基本数据单位,它携带日志数据(字节数组形式)并且携带有头信息,这些 Event 由 Agent 外部的 Source 生成,当 Source 捕获事件后会进行特定的格式化,然后 Source 会把事件推入(单个或多个)Channel 中。可以把 Channel 看作是一个缓冲区,它将保存事件直到 Sink 处理完该事件。Sink 负责持久化日志或者把事件推向另一个 Source。以下是 Flume 的一些核心概念:

(1)Events:一个数据单元,带有一个可选的消息头, 可以是日志记录、avro 对象等。

(2)Agent:JVM 中一个独立的 Flume 进程,包含组件 Source、Channel、Sink。

(3)Client:运行于一个独立线程,用于生产数据并将其发送给 Agent。

(4)Source:用来消费传递到该组件的 Event, 从 Client 收集数据,传递给 Channel。

(5)Channel:中转 Event 的一个临时存储,保存 Source 组件传递过来的 Event,其实就是连接 Source 和 Sink,有点像一个消息队列。

(6)Sink:从 Channel 收集数据,运行在一个独立线程。

Flume 以 Agent 为最小的独立运行单位,一个 Agent 就是一个 JVM。单 Agent 由 Source、Sink 和 Channel 三大组件构成,如下图所示:

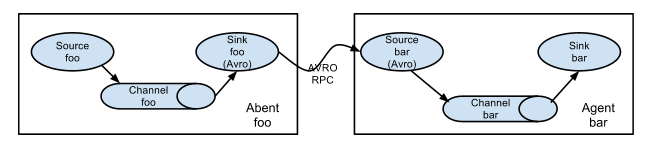

值得注意的是,Flume 提供了大量内置的 Source、Channel 和 Sink 类型。不同类型的 Source、Channel 和 Sink 可以自由组合。组合方式基于用户设置的配置文件,非常灵活。比如:Channel 可以把事件暂存在内存里,也可以持久化到本地硬盘上;Sink 可以把日志写入 HDFS、Hbase、ES 甚至是另外一个 Source 等等。Flume 支持用户建立多级流,也就是说多个 Agent 可以协同工作, 如下图所示:

3 Flume 的安装

3.1 安装 JDK

具体方法略。

3.2 下载安装包并解压

$ wget http://archive.cloudera.com/cdh5/cdh/5/flume-ng-1.6.0-cdh5.7.1.tar.gz

$ tar -xvf flume-ng-1.6.0-cdh5.7.1.tar.gz

$ rm flume-ng-1.6.0-cdh5.7.1.tar.gz

$ mv apache-flume-1.6.0-cdh5.7.1-binflume-1.6.0-cdh5.7.1

3.3 配置环境变量

$ cd /home/Hadoop

$ vim .bash_profile

export FLUME_HOME=/home/hadoop/app/cdh/flume-1.6.0-cdh5.7.1

export PATH=$PATH:$FLUME_HOME/bin

$ source .bash_profile

3.4 配置 flume-env.sh 文件

$ cd app/cdh/flume-1.6.0-cdh5.7.1/conf/

$ cp flume-env.sh.template flume-env.sh

$ vim flume-env.sh

export JAVA_HOME=/home/hadoop/app/jdk1.7.0_79

export HADOOP_HOME=/home/hadoop/app/cdh/hadoop-2.6.0-cdh5.7.1

3.5 版本验证

$ flume-ng version

4 Flume 部署示例

4.1 Avro

Flume 可以通过 Avro 监听某个端口并捕获传输的数据,具体示例如下:

// 创建一个 Flume 配置文件

$ cd app/cdh/flume-1.6.0-cdh5.7.1

$ mkdir example

$ cp conf/flume-conf.properties.template example/netcat.conf

// 配置 netcat.conf 用于实时获取另一终端输入的数据

$ vim example/netcat.conf

# Name the components on this agent

a1.sources = r1

a1.sinks = k1

a1.channels = c1

# Describe/configure the source

a1.sources.r1.type = netcat

a1.sources.r1.bind = localhost

a1.sources.r1.port = 44444

# Describe the sink

a1.sinks.k1.type = logger

# Use a channel that buffers events in memory

a1.channels.c1.type = memory

a1.channels.c1.capacity = 1000

a1.channels.c1.transactionCapacity = 100

# Bind the source and sink to the channel

a1.sources.r1.channels = c1

a1.sinks.k1.channel = c1

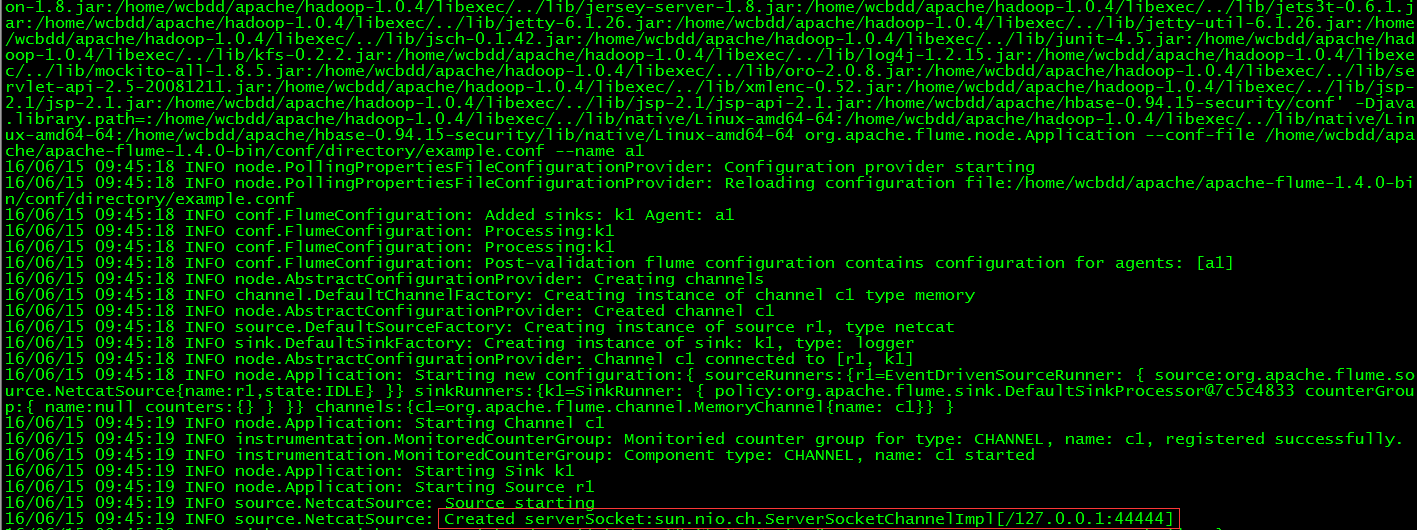

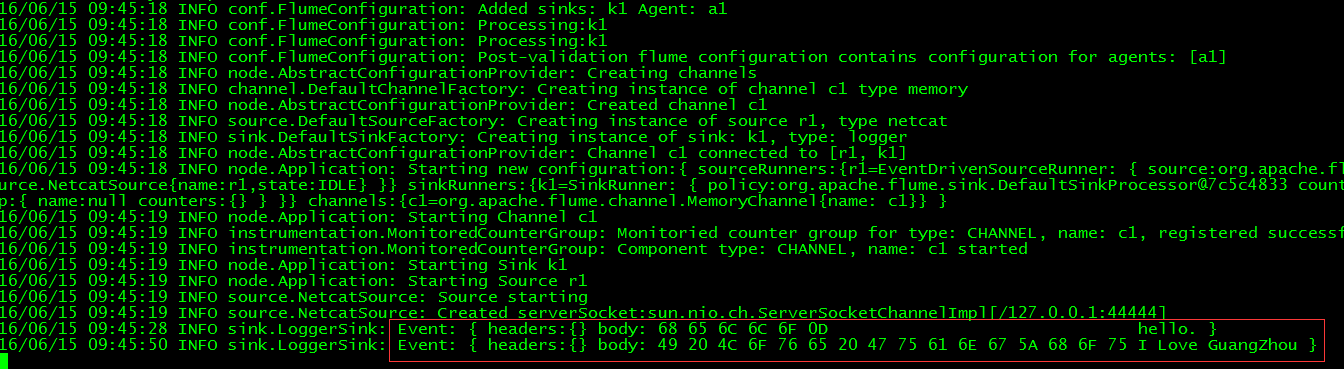

// 运行 FlumeAgent,监听本机的 44444 端口

$ flume-ng agent -c conf -f example/netcat.conf -n a1 -Dflume.root.logger=INFO,console

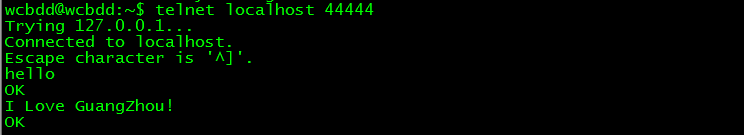

// 打开另一终端,通过 telnet 登录 localhost 的 44444,输入测试数据

$ telnet localhost 44444

// 查看 flume 收集数据情况

4.2 Spool

Spool 用于监测配置的目录下新增的文件,并将文件中的数据读取出来。需要注意两点:拷贝到 spool 目录下的文件不可以再打开编辑、spool 目录下不可包含相应的子目录。具体示例如下:

// 创建两个 Flume 配置文件

$ cd app/cdh/flume-1.6.0-cdh5.7.1

$ cp conf/flume-conf.properties.template example/spool1.conf

$ cp conf/flume-conf.properties.template example/spool2.conf

// 配置 spool1.conf 用于监控目录 avro_data 的文件,将文件内容发送到本地 60000 端口

$ vim example/spool1.conf

# Namethe components

local1.sources= r1

local1.sinks= k1

local1.channels= c1

# Source

local1.sources.r1.type= spooldir

local1.sources.r1.spoolDir= /home/hadoop/avro_data

# Sink

local1.sinks.k1.type= avro

local1.sinks.k1.hostname= localhost

local1.sinks.k1.port= 60000

#Channel

local1.channels.c1.type= memory

# Bindthe source and sink to the channel

local1.sources.r1.channels= c1

local1.sinks.k1.channel= c1

// 配置 spool2.conf 用于从本地 60000 端口获取数据并写入 HDFS

# Namethe components

a1.sources= r1

a1.sinks= k1

a1.channels= c1

# Source

a1.sources.r1.type= avro

a1.sources.r1.channels= c1

a1.sources.r1.bind= localhost

a1.sources.r1.port= 60000

# Sink

a1.sinks.k1.type= hdfs

a1.sinks.k1.hdfs.path= hdfs://localhost:9000/user/wcbdd/flumeData

a1.sinks.k1.rollInterval= 0

a1.sinks.k1.hdfs.writeFormat= Text

a1.sinks.k1.hdfs.fileType= DataStream

# Channel

a1.channels.c1.type= memory

a1.channels.c1.capacity= 10000

# Bind the source and sink to the channel

a1.sources.r1.channels= c1

a1.sinks.k1.channel= c1

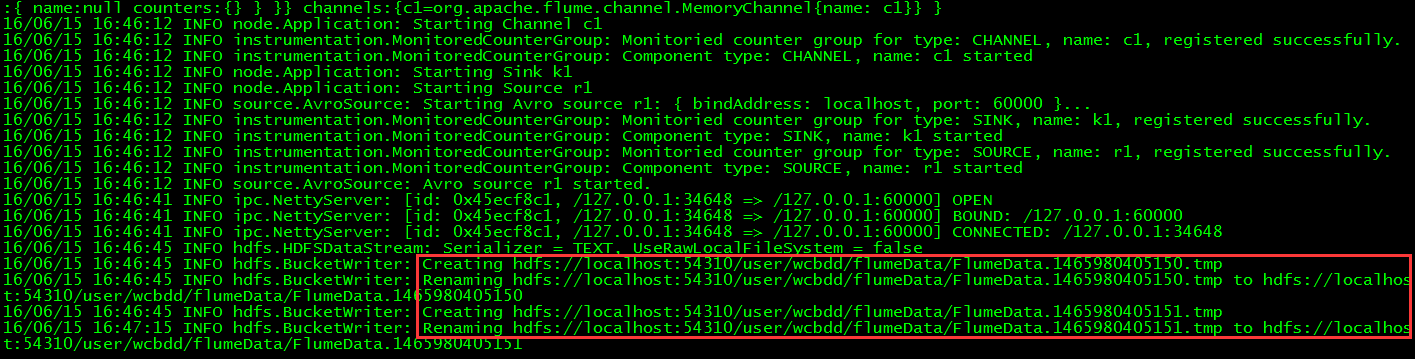

// 分别打开两个终端,运行如下命令启动两个 Flume Agent

$ flume-ng agent -c conf -f example/spool2.conf -n a1

$ flume-ng agent -c conf -f example/spool1.conf -n local1

// 查看本地文件系统中需要监控的 avro_data 目录内容

$ cd avro_data

$ cat avro_data.txt

// 查看写 HDFS 的 Agent,检查是否捕获了数据别写入 HDFS

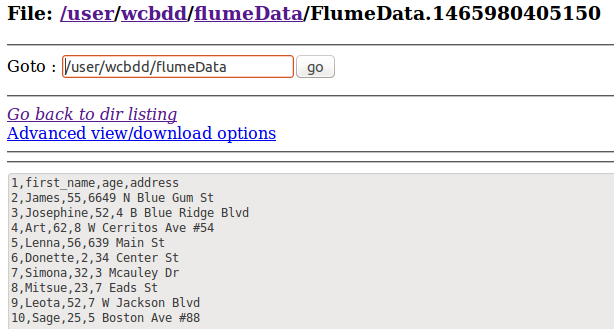

// 通过 WEB UI 查看 HDFS 中的文件

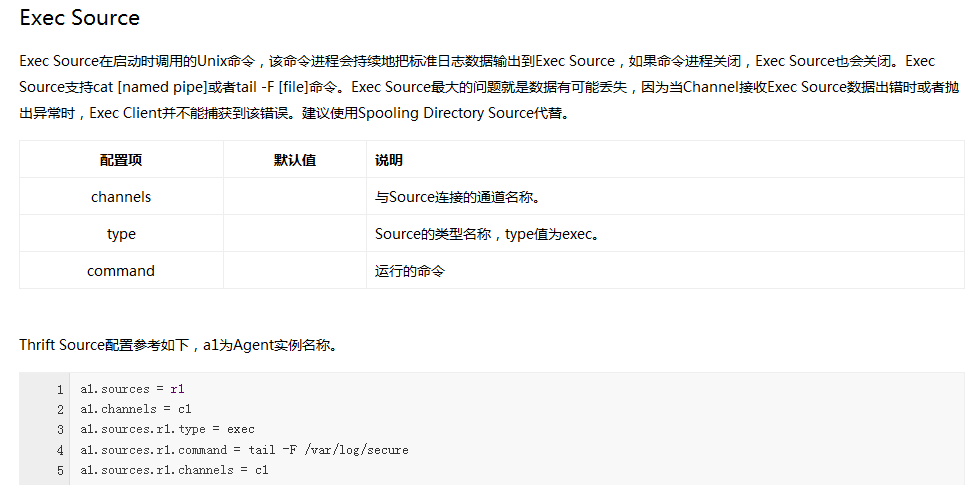

4.3 其它

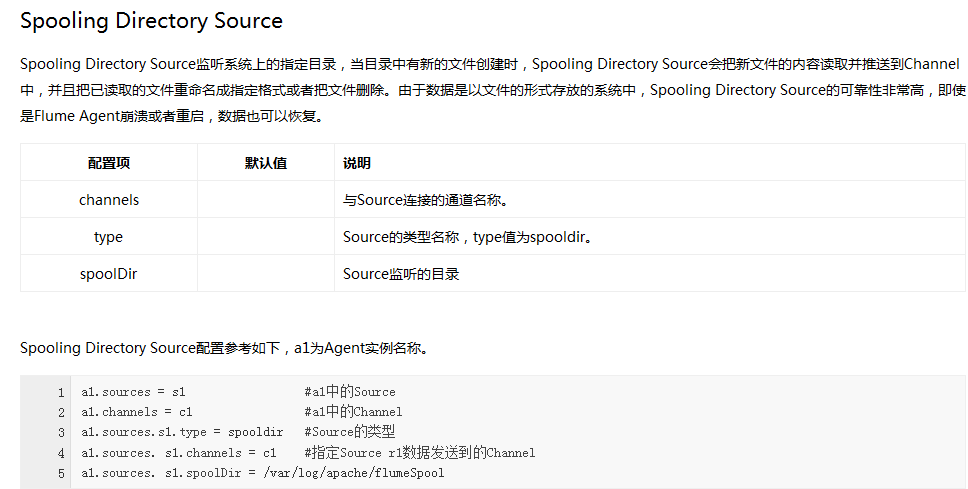

Flume 内置了大量的 Source,其中 Avro Source、Thrift Source、Spooling Directory Source、Kafka Source 具有较好的性能和较广泛的使用场景。下面是 Source 的一些参考资料:

Kafka-Storm 集成部署 http://www.linuxidc.com/Linux/2016-03/129063.htm

Flume 官方文档翻译——Flume 1.7.0 User Guide(unreleased version)http://www.linuxidc.com/Linux/2016-12/138030.htm

Flume + HDFS + Hive 日志收集系统搭建 http://www.linuxidc.com/Linux/2016-12/137959.htm

使用 flume+kafka+storm 构建实时日志分析系统 http://www.linuxidc.com/Linux/2014-09/107382.htm

本文永久更新链接地址 :http://www.linuxidc.com/Linux/2016-12/138722.htm