共计 3362 个字符,预计需要花费 9 分钟才能阅读完成。

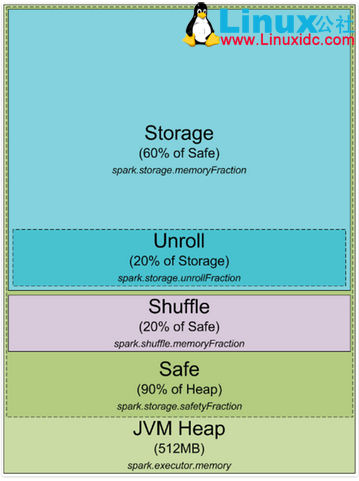

这是 spark1.5 及以前堆内存分配图

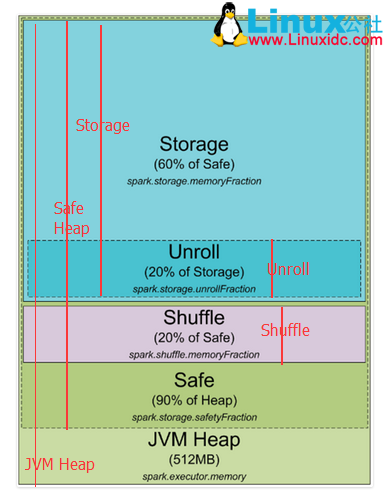

下边对上图进行更近一步的标注,红线开始到结尾就是这部分的开始到结尾

spark 默认分配 512MB JVM 堆内存。出于安全考虑和避免内存溢出,Spark 只允许我们使用堆内存的 90%,这在 spark 的 spark.storage.safetyFraction 参数中配置着。也许你听说的 spark 是一个内存工具,Spark 允许你存储数据在内存。其实,Spark 不是真正的内存工具,它只是允许你使用内存的 LRU(最近最少使用)缓存。所以,一部分内存要被用来缓存你要处理的数据,这部分内存占可用安全堆内存的 60%,这个值在 spark.storage.memoryFraction 参数中配置。所以如果你想知道你可以存多少数据在 spark 中,spark.storage.safetyFraction 默认值为 0.9,spark.storage.memoryFraction 的默认值为 0.6,

Storage= 总堆内存 *0.9*0.6, 所以你有 54% 的堆内存用来存储数据。

shuffle 内存:

spark.shuffle.safetyFraction * spark.shuffle.memoryFraction

spark.shuffle.safetyFraction 默认为 0.8 或 80%,spark.shuffle.memoryFraction 默认为 0.2 或 20%,则你最终可以使用 0.8*0.2=0.16 或 16% 的 JVM 堆内存用于 shuffle。

Unroll 内存:

spark 允许数据以序列化或非序列化的形式存储,序列化的数据不能拿过来直接使用,所以就需要先反序列化,即 unroll。

Heap Size*spark.storage.safetyFraction*spark.storage.memoryFraction*spark.storage.unrollFraction=Heap Size *0.9*0.6*0.2=Heap Size * 0.108 或 10.8% 的 JVM 堆内存。

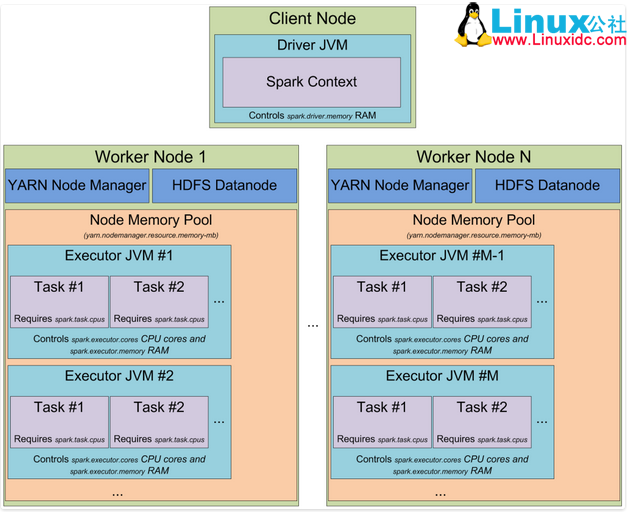

到此为止,你应该就知道 Spark 是如何使用 jvm 内存的了,下边是集群模式,以 yarn 为例,其它类似。

在 Yarn 集群中,Yarn Resource Manager 管理集群的资源(实际就是内存)和一系列运行在集群 Node 上 yarn resource manager 及集群 Nodes 资源的使用。从 YARN 的角度,每一个 Node 都代表了一个可控制的内存资源,当你向 Yarn Resource Manager 申请资源时,它会反馈给你哪个 yarn node manager 可以连接并启动一个 execution container 给你。每一个 execution container 都是一个可以提供堆内存的 JVM,JVM 的位置是由 Yarn Resource manager 选择的。

当你在 Yarn 上启动 Spark 时,你可以指定 executor 的数量(–num-executors flag or spark.executor.instances parameter)、每个 executor 的内存大小(–executor-memory flag or spark.executor.memory parameter)、每个 executor 的内核数量(–executor-cores flag of spark.executor.coresparameter)、每个 task 执行的内核数量(spark.task.cpusparameter),你也可以指定 driver 的内存大小(–driver-memory flag or spark.driver.memory parameter)。

当你在集群中执行某项任务时,一个 job 会被切分成 stages, 每个 stage 会被分成多个 task, 每个 task 会被单独分配,你可以把这些 executor 看成一个个执行 task 的槽池(a pool of tasks execution slots)。如下看一个例子:一个集群有 12 个节点(yarn node manager), 每个节点有 64G 内存、32 核的 CPU(16 个物理内核,一个物理内核可以虚拟成两个)。每个节点你可以启动两个 executors、每个 executor 分配 26G 内存(留一部分用于 system process、yarn NM、DataNode). 所以集群一共可以处理 12 machines * 2 executors per machine * 12 cores per executor / 1 core for each task = 288 task slots。这意味着该集群可以并行运行 288 个 task,充分利用集群的所有资源。你可以用来存储数据的内存为 = 0.9 spark.storage.safetyFraction * 0.6 spark.storage.memoryFraction * 12 machines * 2 executors per machine * 26 GB per executor = 336.96 GB。没有那么多,但是也足够了。

到此,你已经知道 spark 如何分配 jvm 内存,在集群中可以有多少个 execution slots。那么什么是 task,你可以把他想像成 executor 的某个线程,executor 是一个进程,它可以多线程的执行 task.

下边来解释一下另一个抽象概念 ”Partition”,你用来分析的所有数据都将被切分成 partitions, 那么何为一个 partition,它又是由什么决定的?partition 的大小是由你使用的数据源决定的,在 spark 中你可以使用的所有读取数据的方式,大多你可以指定你的 RDD 中有多少个 partitions。当你从 HDFS 中读取一个文件时,Hadoop 的 InputFormat 决定 partition。通常由 InputFormat 输入的每一个 split 对应于 RDD 中的一个 partition,而每一个 split 通常相当于 hdfs 中的一个 block(还有一些其它情况,暂不解释,如 text file 压缩后传过一整个 partition 不能直接使用)。

一个 partition 产生一个 task, 并在数据所在的节点 task slot 执行(数据本地性)

参考译自:https://0x0fff.com/spark-architecture/

更多 Spark 相关教程见以下内容:

CentOS 7.0 下安装并配置 Spark http://www.linuxidc.com/Linux/2015-08/122284.htm

Spark1.0.0 部署指南 http://www.linuxidc.com/Linux/2014-07/104304.htm

Spark 官方文档 – 中文翻译 http://www.linuxidc.com/Linux/2016-04/130621.htm

CentOS 6.2(64 位)下安装 Spark0.8.0 详细记录 http://www.linuxidc.com/Linux/2014-06/102583.htm

Spark 简介及其在 Ubuntu 下的安装使用 http://www.linuxidc.com/Linux/2013-08/88606.htm

安装 Spark 集群(在 CentOS 上) http://www.linuxidc.com/Linux/2013-08/88599.htm

Hadoop vs Spark 性能对比 http://www.linuxidc.com/Linux/2013-08/88597.htm

Spark 安装与学习 http://www.linuxidc.com/Linux/2013-08/88596.htm

Spark 并行计算模型 http://www.linuxidc.com/Linux/2012-12/76490.htm

Ubuntu 14.04 LTS 安装 Spark 1.6.0(伪分布式)http://www.linuxidc.com/Linux/2016-03/129068.htm

Spark 的详细介绍:请点这里

Spark 的下载地址:请点这里

本文永久更新链接地址:http://www.linuxidc.com/Linux/2016-08/133775.htm